La prochaine génération de systèmes d’armes disposera d’un niveau d’automatisation beaucoup plus performant que celui que nous connaissons à ce jour. Les armées doivent clarifier les concepts d’emploi juridique, éthique et opérationnel associés.

Autonomie et respect de la Règle pour les robots militaires : considérations sémantiques et point de vue de la doctrine interarmées

En matière d’armement des drones, des débats internes ont empêché toute initiative française pendant près de 15 ans jusqu’à ce que la ministre des Armées, Florence Parly, annonce l’armement des drones Reaper (1) lors de l’Université d’été de la Défense de 2017, décision dont on notera qu’elle est intervenue après l’armement de leurs drones par les Américains, les Russes, les Chinois, les Israéliens, les Anglais… et surtout après l’utilisation de drones armés par Daech contre nos propres forces. Ainsi, il aura donc fallu être rattrapé par la réalité des opérations militaires et la réalité de l’équipement des armées étrangères pour clore des débats internes juridico-éthiques sans pour autant corriger les biais de perception qui accompagnent le monde de la robotique.

Il est incontestable que la prochaine génération de systèmes d’armes disposera d’un niveau d’automatisation beaucoup plus poussé et performant que celui que nous connaissons à ce jour. À moins de vouloir courir le risque d’une nouvelle paralysie de nos processus de décision, nous devons donc anticiper l’arrivée de ces améliorations technologiques et clarifier la terminologie, les concepts d’emploi opérationnel associés à des niveaux d’automatisation accrus et les corpus juridique et éthique accompagnant l’ensemble.

Des choix terminologiques bien hasardeux

Les débats sociétaux et l’agitation médiatique auxquels nous assistons sur l’autonomie et l’Intelligence artificielle (IA) n’auraient probablement pas eu lieu si nous avions gardé la terminologie scientifique et technique initiale, certes peu attrayante, à savoir « traitement du signal », « traitement des données », « algorithmie » et « autoatisme ». L’utilisation de la nouvelle terminologie (intelligence, réseau de neurones, algorithme génétique, autonomie…), qui s’appuie sur des caractéristiques du vivant ou se compare clairement à l’homme, est malheureusement source de confusions et de fantasmes dont on a du mal à gérer les conséquences. Elle présente néanmoins le gros avantage de la vulgarisation facile et donc d’un marketing efficace : un doctorat en IA est nettement plus vendeur qu’un doctorat en automatisme industriel…

Malgré cette nouvelle terminologie, et sans dénier les vrais potentiels de l’IA, nous devons rester lucides quant aux performances réellement accessibles, pour ne pas dire limitées, de cette technologie car, à ce jour, il apparaît clairement que l’IA reste plus artificielle qu’intelligente. Les déconvenues rapportées dans l’emploi des techniques d’IA dans de nombreux domaines (assistants vocaux, chatbot…) démontrent régulièrement que les seuls mérites de l’IA résident plus dans la puissance de calcul et la réactivité que dans la qualité de ses interactions avec l’humain, notamment dans des cas non prévus ou non appris.

Un robot peut-il être autonome ?

L’autonomie, tout comme l’intelligence, est une des caractéristiques de l’homme qui a acquis un certain savoir-faire et des connaissances. L’homme, par nature autonome, est capable de percevoir son environnement, de le comprendre et de s’y adapter, voire éventuellement, dans certains cas, de le modifier. Étymologiquement, l’autonomie consiste à être gouverné selon ses propres règles : l’homme est donc bien autonome, puisqu’il lui est toujours possible de sortir, à ses risques et périls, du cadre que lui est fixé, que ce soit par des processus légaux ou illégaux, éventuellement avec violences. Dans de nombreux cas, le non-respect de la règle et la capacité à changer les règles établies dans des environnements nouveaux permettent à l’homme, par un processus quasi-darwinien, d’évoluer. La désobéissance est donc également le propre de l’homme et une conséquence de l’autonomie. Il est d’ailleurs intéressant de voir aux États-Unis se mêler, dans un mariage étrange, les notions de leadership et de désobéissance.

Dans cette acception de la notion d’autonomie qui consiste à pouvoir s’affranchir du cadre et des règles énoncés, accepte-t-on l’idée qu’un système (un drone ou un robot) puisse en toute autonomie définir ses propres règles voire désobéir ? Dans cette hypothèse, qui serait responsable des conséquences du non-respect de la règle ?

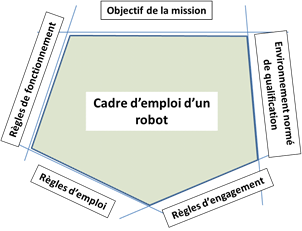

Robot et cadre d’emploi fondamental

Au regard des enjeux de l’automatisation des systèmes, il devient nécessaire de formaliser ce que devrait être un cadre d’emploi fondamental des systèmes automatisés qui pourrait être défini de la façon suivante :

Un robot évolue dans un cadre d’emploi fondamental constitué de :

– sa mission/fonction, qui est bornée dans le temps et dans l’espace ;

– un environnement « normé », pour lequel le robot a été conçu et qualifié ;

– des règles de fonctionnement interne gérant ses fonctions « vitales » (équilibre, gestion de l’énergie…) ;

– des règles d’emploi ou règles de fonctionnement externe gérant ses interactions avec son environnement (code de la route, règles de circulation aérienne générale pour le domaine aéronautique…) ;

– des règles d’engagement pour les systèmes armés.

Schéma n° 1

Bien entendu, en théorie, un robot n’est pas censé sortir de son cadre d’emploi, mais que se passe-t-il s’il en sort malgré tout, soit par accident, soit du fait d’une incomplétude de son cadre ?

La sortie du cadre d’emploi fondamental doit probablement faire l’objet de spécifications particulières : ainsi, un aéronef qui sort de ses règles de fonctionnement (enveloppe de vol) devrait probablement tout faire pour revenir dans son enveloppe de vol, tandis qu’un robot terrestre pourrait probablement se contenter de se mettre en veille et d’attendre une reprise en main par un opérateur. Chaque cas étant différent, il reviendra probablement aux spécificateurs de préciser, en fonction des risques de sortie du cadre d’emploi, quel serait le comportement nominal du robot.

Apprentissage, mémorisation et autonomie

On évoque souvent le fait qu’un robot pourrait faire de « l’apprentissage » en cours de mission. Les travaux en matière d’apprentissage, transverses à plusieurs sciences (neurosciences, psychologie, informatique…), donnent lieu à de nombreuses théories et on peut s’accorder sur le fait qu’un processus d’apprentissage se traduit par un changement significatif et permanent des savoir-faire, des savoirs et des connaissances, et donc du comportement d’un système. Dans le cas de la robotique, « l’apprentissage » se distingue donc de la simple mémorisation ou découverte d’un environnement, en ce que l’apprentissage modifie les règles de fonctionnement et d’emploi d’un robot.

En résumé, la découverte d’un nouvel environnement par un robot peut soit alimenter ses algorithmes d’optimisation pour l’accomplissement de sa mission, auquel cas il s’agit de mémorisation, soit alimenter ses règles de fonctionnement et d’emploi auquel cas il s’agit bien d’un apprentissage.

Ainsi, la mémorisation de la fable « Le lièvre et la tortue » de La Fontaine ne constitue pas un apprentissage fondamental en soi, seul constitue un apprentissage le fait que « rien ne sert de courir, il faut partir à point » devient alors une nouvelle règle modelant un comportement. Cette règle n’ayant d’ailleurs rien d’absolu, elle ne sera activée par ceux qui la jugent pertinente que dans certains scénarios particuliers.

De même, la mémorisation d’une cartographie tridimensionnelle par un véhicule dit « autonome » n’aboutit pas à modifier ses règles de fonctionnement ni le Code de la route, mais seulement à alimenter son algorithme d’optimisation qui lui permet d’accomplir son déplacement au mieux.

Enfin, un joueur d’échec électronique à qui on va demander d’intervenir en cours de partie, va « mémoriser » la position initiale des pièces sur l’échiquier, en déduire le meilleur coup possible, mais en aucune manière réinventer les règles du jeu d’échec et encore moins sortir du cadre de l’échiquier.

Il est tout à fait concevable que l’algorithme d’optimisation de la mission (aller le plus rapidement possible d’un point A à un point B, gagner en un minimum de coups…) puisse, en cours de mission, identifier qu’une classe de solutions est particulièrement efficace, sans remettre en cause le cadre d’emploi fondamental du robot qui lui est imposé par l’homme. Il s’agirait alors d’une forme d’apprentissage autonome mais bornée par le cadre d’emploi du robot et surtout limitée à la fonction d’optimisation des performances de sa mission. Il conviendra alors de s’assurer que cet apprentissage est généralisable et n’est pas le résultat d’une base d’apprentissage biaisée ou trop restreinte. D’une certaine façon, c’est ce type d’apprentissage qui a été utilisé par AlphaGo pour « apprendre » à gagner au jeu de Go. Mais, de toutes évidences, AlphaGo, n’a pas réinventé les règles du jeu ou inventé un nouveau jeu.

Est-il par ailleurs envisageable d’avoir un apprentissage entièrement autonome, c’est-à-dire qu’un système à partir de données a priori quelconques élabore des règles de fonctionnement ou d’emploi qui sortent du cadre d’emploi fondamental, le tout sans validation par l’homme. Dans les faits, ce type de système existe déjà dans le monde cybernétique, mais ce sont ces mêmes moteurs d’apprentissage qui sont devenus racistes et sexistes du fait que l’environnement dans lequel ils ont été plongés était raciste et sexiste.

La tentation d’un apprentissage autonome (donc non-supervisé et non validé par l’homme) est extrêmement forte car d’une part, elle permet de traiter des quantités de données gigantesques en temps quasi-réel et d’autre part, elle permet de s’affranchir des coûts monstrueux de la validation d’une base de données et de l’algorithme final par l’homme. L’apprentissage autonome est néanmoins particulièrement dangereux car il n’y a que l’homme pour s’assurer, conceptuellement, que le domaine d’apprentissage n’est pas biaisé et que les résultats de l’apprentissage sont solides. Une « doctrine » possible pour « l’apprentissage autonome » consisterait donc à n’en autoriser l’utilisation que dans les stades de recherche et de développement. Lors du passage en production, la validation par l’homme pourrait alors être obligatoire.

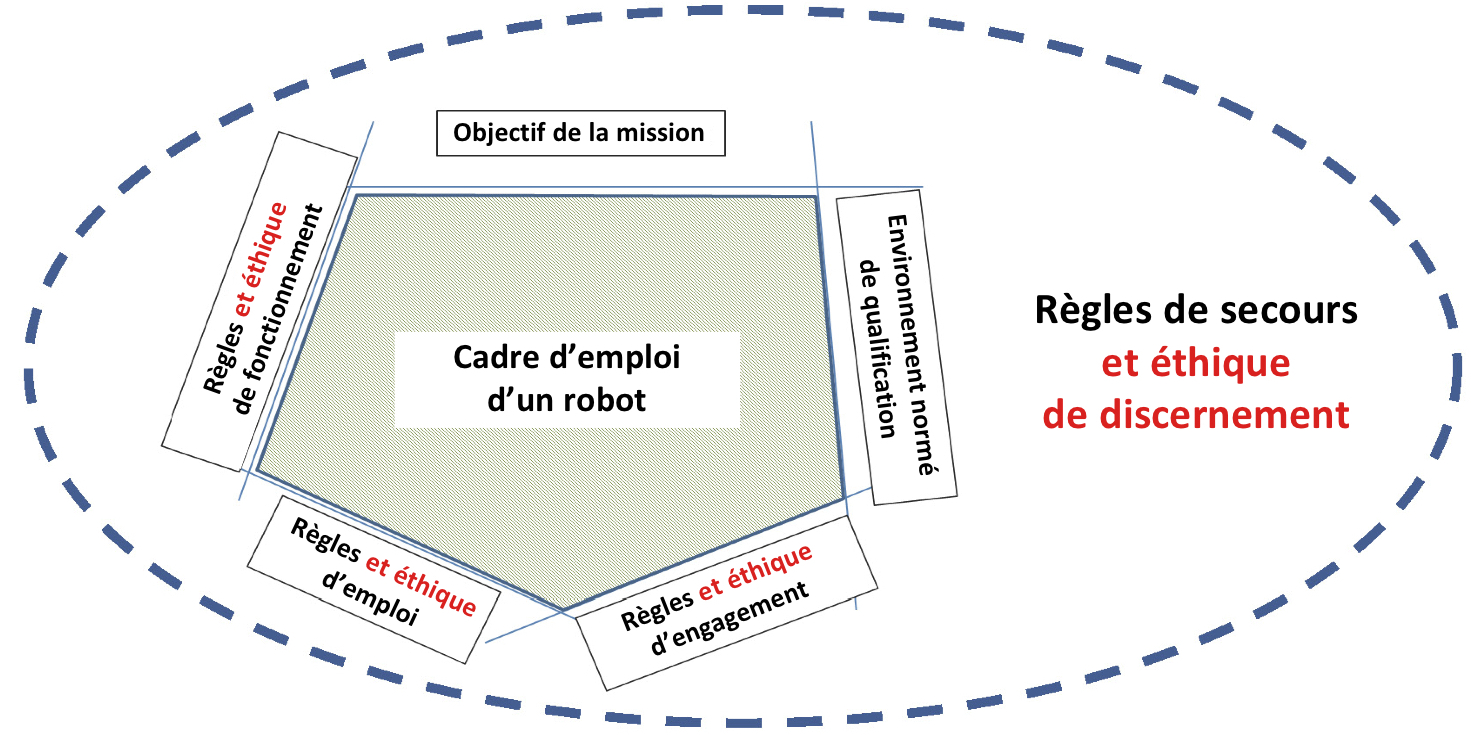

Et l’éthique…

Comme mentionné dans notre article « Quelle éthique opérationnelle pour les systèmes automatisés et l’intelligence artificielle ? » (RDN n° 809, avril 2018, p. 89-92), l’éthique appliquée (et opérationnelle) peut être décomposée en trois branches :

• L’éthique d’emploi : il s’agit de l’usage d’un système automatisé qu’un utilisateur autorise. Un emploi non-éthique d’une technologie ne doit pas rendre cette dernière non-éthique mais pose la question de la responsabilité morale et juridique de l’utilisateur en cas d’accident.

• L’éthique de conception : il s’agit de s’assurer, dès la conception, qu’un certain nombre de règles et de précautions seront prises, notamment celles relatives au respect du droit.

• L’éthique de discernement : cette sous-catégorie de l’éthique concerne plus particulièrement des systèmes où l’IA devra faire preuve d’un minimum de discernement dans le cadre de dilemmes portant sur la sécurité des personnes et des biens, et faire le choix du moindre mal.

Schéma n° 2

À titre d’illustration, l’éthique d’emploi consisterait donc pour un véhicule particulier à rouler à 70 km/h sur une route limitée à 90 km/h mais jugée comme dangereuse, tandis que l’éthique de conception consisterait à brider le véhicule à 160 km/h au regard de ce qu’aucune route n’autorise de telles vitesses. De toute évidence, une ambulance ou un véhicule de secours auraient d’autres règles éthiques de fonctionnement et d’emploi. L’éthique opérationnelle s’adapte donc bien à chaque cas particulier. Quant à l’éthique de discernement, elle permettrait en cas d’accident, de choisir la solution « la moins pire ».

Les règles éthiques issues de ces trois branches de l’éthique opérationnelle viennent donc compléter le cadre d’emploi fondamental d’un système tel que défini précédemment (règles de fonctionnement, règles d’emploi, règles d’engagement, mission et environnement normé de qualification). L’éthique de discernement aurait néanmoins une place à part en ce qu’elle traite des situations qui sont en dehors du cadre d’emploi : elle serait l’éthique à utiliser dans les cas non-conformes proposant notamment des modèles de comportement ou de décision qui permettent au système de choisir la moins pire des solutions en cas d’accident.

L’identification des règles d’éthique d’emploi, de conception et de discernement devra se faire dans le cadre de groupes de travail ou de comités d’éthique appliquée particuliers avec un processus méthodologique formalisé.

Quand la règle n’est pas tout à fait la règle

Vous êtes dans un véhicule, sur une voie à double sens mais séparée par une ligne blanche. Une personne traverse subitement la chaussée : la seule alternative pour l’éviter consiste à franchir la ligne blanche. L’humain devinera naturellement qu’il lui faut transgresser la règle de l’interdit (franchir la ligne blanche) : il y a donc une tolérance, pas nécessairement énoncée, sur le non-respect des règles du Code de la route. La règle serait donc « floue » et d’une certaine façon négociable en fonction du contexte car un principe de niveau supérieur s’applique : le principe de nécessité.

De fait, il apparaît que le raisonnement humain est intrinsèquement fondé sur le maniement des règles floues ; les règles sont d’une certaine façon toujours interprétables, négociables ou transgressables en cas de force majeure, et si besoin, il est toujours possible d’inventer de nouvelles règles voire des règles d’ordre supérieur. Dans certains cas, la règle peut même être remplacée par l’intuition dont sa forme la plus extrême, à savoir l’intime conviction de l’action juste.

L’intime conviction consiste à prendre en compte dans un jugement personnel des éléments variés, intuitifs, contextuels qui ne peuvent constituer des preuves formelles. Le « raisonnement » intuitif menant à l’intime conviction n’est pas modélisable et ne peut donc être programmé dans un algorithme.

La règle est donc potentiellement imparfaite et seul l’humain aurait le pouvoir de la parfaire, voire de l’ignorer, dans un possible ultime recours de la raison. À défaut d’intuition et de conviction, nos robots devront donc disposer de règles « de secours » pour gérer les situations de sortie du cadre d’emploi fondamental et les situations de dilemme, c’est-à-dire des situations où des règles sont insuffisantes voire peuvent être contradictoires.

Le robot-skieur, une illustration utile

Un robot-skieur descendant une piste bleue a été présenté à l’occasion des Jeux olympiques d’hiver 2018 à PyeongChang. Si le côté ludique de la démonstration était évident, les performances du robot étaient encore très loin d’égaler celles d’un skieur amateur. D’un strict point de vue conceptuel, ce robot disposait bien d’un cadre d’emploi fondamental constitué de :

– une mission : partir d’un point A pour aller à un point B et s’arrêter après avoir franchi le point B ;

– d’un environnement normé de qualification (admettons que le robot ait été conçu pour des pistes « bleues ») ;

– de règles de fonctionnement consistant à maîtriser en tout instant la sécurité du robot (garder l’équilibre…) ;

– de règles d’emploi : règles de bonne conduite sur les pistes, à savoir éviter les obstacles et les personnes, y compris mobiles, et ne pas sortir de la piste.

À l’intérieur de ce cadre, le robot-skieur est donc libre sur la base d’un certain nombre de descentes, d’affiner la connaissance d’une piste bleue particulière lui permettant ainsi d’optimiser son déplacement selon des critères qui lui sont imposés (temps de descente, etc.). En aucun cas, l’exploration de la piste bleue ne peut aboutir à redéfinir des règles fondamentales du robot car si le robot skieur devait changer de piste bleue, il serait alors biaisé dans son comportement par la piste bleue initiale qui n’est pas nécessairement complètement représentative de l’ensemble des pistes « bleues ». Que se passerait-il néanmoins si le robot-skieur sortait de son cadre fondamental, a priori accidentellement, et se retrouvait subitement sur une piste noire non damée ? La seule façon pour le robot d’effectuer sa « mission » consisterait alors à explorer de nouvelles règles de fonctionnement et d’emploi non apprises (comme glisser sur les fesses par exemple). C’est conceptuellement possible, mais cela pose trois problèmes fondamentaux :

• D’ordre philosophique : accepte-t-on que le robot puisse, sans validation par l’homme, déroger au cadre fondamental d’emploi et aux règles qui lui ont été initialement fixés ?

• D’ordre pratique : comment s’assurer que de nouvelles règles « inventées » par le robot ne soient pas contraires à l’intérêt des hommes ? Si on accepte que le robot puisse inventer des règles devant protéger l’intérêt des hommes, comment définir informatiquement l’intérêt des hommes ?

• D’ordre technique : on ne sait pas démontrer que l’apprentissage autonome permet de résoudre des problèmes combinatoires complexes dans des environnements imprévus et non modélisés (par exemple, absence de modèle de piste sans neige dans le robot-skieur). De plus, la confrontation d’un système à un environnement auquel il n’est pas préparé lui est généralement fatale. En effet, la seule façon de « découvrir » un nouvel environnement consiste à faire de l’apprentissage par renforcement, c’est-à-dire une succession d’essais dont la plupart sont des échecs.

On conçoit bien que si le robot-skieur est conçu et qualifié pour des pistes bleues, il n’est pas raisonnable de le lancer dans un champ de bosses ou sur une piste noire. Néanmoins, un robot-skieur se trouvant dans une situation de risque de collision avec un skieur humain devrait disposer d’un modèle d’éthique de discernement lui permettant par exemple de tomber afin d’éviter la collision. Ce modèle de comportement éthique autorise alors le robot à prioriser les règles et à affecter à sa sécurité une pondération moindre que celle liée à la sécurité d’êtres humains.

En conclusion, un robot qui sortirait de son cadre d’emploi fondamental aurait peu de chance de survie, en effet, l’existence d’algorithmes d’IA pour assurer cette fonction de « survie » n’est à ce jour ni démontrée, ni d’actualité et est même pour certains très improbable. Les processus d’apprentissage et d’adaptation à de nouveaux environnements non prévus, radicalement différents de ceux connus sont généralement fatals, y compris pour l’homme.

Les adeptes de science-fiction pourront évoquer la capacité de mutation de certains algorithmes qui pourraient par le biais des hasards de la mutation tomber sur la bonne solution. Pourquoi pas, mais en matière informatique, les bugs naturels suffisent déjà largement aux dysfonctionnements.

Le point de vue de la doctrine interarmées en matière d’automatisation

Pour les forces françaises, plusieurs éléments concourent à rendre de plus en plus nécessaire le recours à des systèmes d’armes présentant un degré avancé d’automatisation :

– De multiples engagements sur différents théâtres, notamment dans le cadre de la lutte contre le terrorisme.

– Un modèle d’armée qui repose sur un nombre « relativement » limité d’hommes et qui, pour être à la hauteur des missions qui lui sont confiées sur le territoire national ou à l’extérieur, doit compenser par un recours à des moyens matériels de plus en plus automatisés et de haute technologie.

– Des situations au combat complexes et évolutives, appelant parfois des réactions très rapides. Celles-ci rendent nécessaire le recours à la technologie pour aider, traiter et analyser un nombre important de données en des temps très brefs.

– Des milieux très hostiles ou dangereux (grottes, environnements pollués, espaces hostiles à l’homme…).

La doctrine interarmées se devait donc de réfléchir à l’emploi des robots et des drones et aux conséquences de l’arrivée de l’intelligence artificielle dans ces systèmes qui en permet une automatisation performante, ce que certains appellent l’autonomisation.

Qu’est-ce que la doctrine ? La doctrine interarmées est un ensemble de principes qui guide l’emploi des forces (avec leurs équipements). Une doctrine doit préparer la guerre de demain et s’appuyer sur des scénarios futurs possibles. Une doctrine bien née se doit donc d’être un minimum prospectiviste et ne pas se contenter de décrire une situation présente, voire passée.

C’est dans ce cadre qu’est paru un concept exploratoire interarmées (2) portant sur « l’emploi de l’intelligence artificielle et des systèmes automatisés ». Que dit la doctrine ?

• Que les systèmes automatisés peuvent être supervisés, semi-autonomes ou pleinement autonomes.

• Que la notion de « système autonome » est à éviter car prêtant à confusion, et n’est pas suffisamment discriminante sur la nature exacte du système : il vaut mieux parler de systèmes automatisés semi-autonomes et de systèmes automatisés pleinement autonomes.

• Que les systèmes semi-autonomes sont des systèmes subordonnés à la chaîne de commandement qui garde la responsabilité de l’emploi de ces systèmes.

• Que les systèmes pleinement autonomes sont des systèmes non subordonnés à une chaîne de commandement, sont capables entre autres de redéfinir leur cadre d’emploi (règles, mission…), et qu’outre le fait qu’il s’agisse de systèmes qui n’existent pas, il n’y a pas à ce jour de concept d’emploi identifié associé à ce type de système dans les armées conventionnelles respectueuses du droit international.

Néanmoins, il convient de noter qu’un emploi terroriste d’un système pleinement autonome, s’affranchissant non seulement du droit, mais également des conséquences de l’emploi, est tout à fait possible. On aurait alors une arme « sale », dont le seul propos serait de semer la terreur et la confusion.

Pour la doctrine interarmées, un système doit rester subordonné à un commandement humain et les principes de responsabilité du commandement et de respect du droit international doivent demeurer.

Ce lien de subordination vaut en particulier pour la décision d’emploi et la délimitation du cadre d’emploi qui doivent appartenir à l’homme. Un système capable de s’assigner lui-même des objectifs et/ou de modifier sans validation humaine, en cours de mission, le cadre d’emploi qui lui avait été fixé pour celle-ci, pourrait être considéré comme un Système d’armes létal autonome (Sala).

Le respect du droit international humanitaire

Fondamentalement, le droit international repose sur quatre grands principes : humanité, nécessité, distinction et proportionnalité.

Les débats à l’ONU en matière de Sala font apparaître trois grands types d’arguments.

Le premier, développé par les ONG, développe l’idée que les technologies de la robotisation, où l’homme ne risque plus nécessairement sa vie, baissent le seuil d’engagement des armées, qui, ne risquant rien, sont alors plus susceptibles d’employer la force. Il y aurait donc de facto un abaissement du seuil d’emploi de la force.

Le deuxième argument qui commence à être développé, notamment par les États-Unis, postule que la robotisation est de nature à garantir un meilleur respect du droit international humanitaire. En effet, la robotisation constitue une nouvelle alternative dans la panoplie du décideur qui peut s’avérer dans des scénarios particuliers une option tout à fait intéressante. Dans des combats de haute intensité en zone urbaine, par exemple, des systèmes automatisés performants feraient probablement plus de place à la distinction et à l’action chirurgicale que des combats rapprochés où des civils peuvent être utilisés en bouclier humain. À titre d’illustration sur l’ampleur des enjeux, on peut se reporter à la libération de Mossoul par les forces irakiennes en 2017 : les résultats sont édifiants avec plusieurs milliers de civils pris en otage et tués, victimes de l’État islamique mais aussi des bombardements et de la coalition ; une ville détruite dont la reconstruction coûtera plusieurs milliards de dollars, sans compter les pertes de l’ordre de 30 % dans la Golden Division, la division d’élite de l’Armée irakienne.

Le dernier argument alimentant les débats sur les Sala est lié au devoir d’efficacité des armées qui doivent pouvoir mener leurs actions et défendre le droit. Cette nécessité entraîne le devoir de s’armer des technologies les plus efficientes.

Force est de constater que les trois arguments sont entendables. Dans ces conditions, il n’est pas évident qu’un nouveau droit international naisse des travaux sur les Sala, les pays les plus influents (et les plus concernés) ne voyant pas nécessairement d’un bon œil une limitation de leur capacité opérationnelle alors même que les technologies de l’automatisation et de la robotisation font apparaître des gains de performances inégalés.

Au regard des éléments précédents, on conçoit que les systèmes dans les futurs proche et moyen seront des systèmes de plus en plus automatisés, subordonnés à une chaîne de commandement, et régis par les seules règles qui lui ont été données par le commandement.

* * *

L’autonomie de décision est le propre de l’homme et du vivant, et l’association du qualificatif « autonome » à des technologies informatiques est à ce jour un contresens, de même que tout programmeur sait bien qu’une machine ne décide pas et ne fait qu’exécuter une suite d’instructions informatiques programmée directement ou indirectement par l’homme. Ainsi, affirmer que la machine « décide » concourt principalement à nier la responsabilité de l’homme dans sa programmation informatique.

Nous avons commis collectivement (le monde scientifique, le monde industriel, les médias…) l’erreur d’un choix sémantique et terminologique portant à la confusion en calquant sur le monde matériel des caractéristiques du monde du vivant : apprentissage, intelligence, autonomie… Si certains y trouvent un intérêt à court terme, nous devons désormais en assumer les conséquences et gérer les fantasmes que ces choix génèrent, car nous nous retrouvons désormais dans la situation d’un enfant à qui on a raconté des histoires de Frankenstein et dont on s’étonne qu’il fasse des cauchemars.

Il devient de plus en plus indispensable que les « sachants » affirment que tant que l’on restera sur de l’intelligence artificielle faible (et tout porte à croire que l’IA forte pourrait n’être qu’une utopie), basée sur des automatismes et des algorithmes, l’homme restera responsable de son œuvre et maître de son destin. Un gendarme de l’IA et des comités d’éthique seront néanmoins probablement nécessaires pour accompagner les transformations sociétales profondes à venir.

Quant au monde militaire, il n’échappe pas à ce besoin de clarification terminologique, de clarification des concepts opérationnels, de principes éthiques, inhérent à toute nouvelle technologique, et surtout de réaffirmation de la place de l’homme dans l’utilisation de la technologie, cette dernière devant lui rester subordonnée. ♦

(1) MQ-9 Reaper : drone aérien américain longue endurance à des fins d’observation et pouvant être armé. Les Reaper français achetés initialement n’étaient pas armables.

(2) CICDE, CEIA 3.0.2_I.A.&SYST-AUT(2018) n° 75/ARM/CICDE/NP du 19 juillet 2018.