Le déploiement de systèmes robotisés semi-autonomes semble inéluctable de par les avantages qu’ils offriront sur le champ de bataille. Pour accompagner cette évolution, il impose en revanche une formation poussée et anthropocentrée du chef militaire à une nouvelle éthique de responsabilité.

La nécessaire place du chef militaire dans les systèmes d’armes robotisés autonomes

La polémologie regorge de ruptures tactiques ou stratégiques consécutives à l’invention de systèmes d’armes découlant de l’évolution technologique. On remarquera que l’imagination humaine n’ayant guère de limites, chaque invention fait évoluer un ordre établi : les us et coutumes de la guerre. Ainsi, durant le deuxième Concile de Latran en 1139, l’arbalète fut considérée comme une arme perfide puisque son carreau perçant les armures rompait l’ordre séculaire du combat chevaleresque et le code d’honneur qui l’accompagnait. L’évolution de la conflictualité en Occident a connu une inflexion très sensible au moment de la Révolution française. En effet, alors que les Princes s’affrontaient pour le contrôle de terres ou de populations au moyen d’armées professionnelles dans des guerres circonscrites aux gens de l’art, la levée en masse de troupes parmi la population a introduit une dimension idéologique nouvelle dans la guerre. C’est au nom de la « Liberté ou la mort » que les armées françaises ont envahi l’Est de l’Europe pour libérer les peuples des supposés tyrans qui les oppressaient. Le XIXe siècle a mêlé à la dimension idéologique, l’industrialisation des équipements et a donné une grande importance à l’économie dans la conduite de la guerre devenue industrielle avant de devenir totale.

Dans ce cadre, les deux guerres mondiales ont véhiculé leur lot d’horreurs et ont conduit d’ailleurs les philosophes tels qu’Hans Jonas à prôner une nouvelle éthique de responsabilité tenant compte de l’impact inédit des récentes inventions idéologiques, scientifiques et technologiques sur l’humanité et son environnement. C’est partant de ce constat que, dans le cadre des Nations unies, les Conventions de Genève et leurs Protocoles additionnels se sont efforcés d’humaniser la guerre.

L’innovation technologique ces dernières décennies s’est accélérée à tel point que le déploiement de systèmes d’armes robotisés autonomes sur le champ de bataille est imminent et place le chef militaire face à des questions d’ordres tactiques, techniques, logistiques mais avant tout éthiques et politiques. En d’autres termes, si les bénéfices du déploiement sur le champ de bataille d’un robot de surveillance ou de déminage semblent à première vue incontestables, qu’en est-il de la responsabilité éthique et juridique du chef engageant un Sala (Système d’armes létal [à décision] autonome) capable de supprimer des vies humaines sans qu’un homme soit dans la boucle décisionnelle ?

Aborder la question de la place du chef dans l’emploi de systèmes robotisés autonomes requiert, au préalable, de définir clairement les ressorts et contours de cette fameuse autonomie. Raisonner à partir de l’économie générale d’un conflit permettra de saisir les enjeux et conditions de l’emploi des robots sur le champ de bataille. Or, derrière ces enjeux et conditions, au-delà des cahiers des charges et procédures environnant leur déploiement, le chef se trouve confronté aux questions éthiques, au sens de l’action et ainsi de sa propre responsabilité dans la mise en œuvre. Dans cette perspective, la formation humaine des chefs est d’autant plus importante que l’autonomie de machines placées à sa disposition limite voire annihile l’interaction entre humains, le fameux dialogue de commandement indispensable au déploiement de l’autorité sur le champ de bataille.

Retour sur la notion d’autonomie

L’autonomie (du grec autos : soi-même et nomos : loi, règle) pourrait se définir pour un système comme une capacité à se gérer par lui-même. Si nous nous référons au concept exploratoire interarmées sur l’Emploi de l’intelligence artificielle et des systèmes automatisés du CICDE (1), l’autonomie est la « Capacité d’un système ou d’une fonction à agir sous la supervision d’une programmation, selon ses tâches, ses règles, ses états internes et ses connaissances, sans intervention extérieure » (2).

Ainsi, selon ce document, le système autonome est « un système exécutant ses tâches sans intervention humaine au-delà de la programmation initiale ». Il rentre dans ce « mode autonome » à partir du moment où le militaire qui en a la responsabilité le déploie en activant ce mode pour un usage à des fins opérationnelles.

Outre l’absence d’autonomie, c’est-à-dire le système téléopéré, y apparaissent trois types de systèmes regroupés sous le vocable automatisés :

• Le système supervisé, où les tâches de base sont automatisées et où l’opérateur humain supervise en permanence la situation.

• La semi-autonomie : où le système exécute des tâches de très haut niveau (3) mais sans modifier sa programmation ni ses règles de fonctionnement, d’emploi ou d’engagement, ni sa mission sans intervention humaine, et qui garde des liens de communication et de contrôle avec la chaîne de commandement militaire.

• La pleine autonomie : où le système pleinement autonome ne dispose pas de liens de communication ou de contrôle, donc de subordination, avec la chaîne de commandement, et peut posséder des capacités d’auto-apprentissage autonome. Sa programmation initiale peut être modifiée sans intervention humaine.

Rajoutons que la perception de l’autonomie d’un système est avant tout donnée par la perception de son comportement qui, à la différence de l’automatisme, ne peut être entièrement défini par avance. Il peut donc être perçu comme imprévisible lors de l’exécution d’une tâche ou d’une mission, même si l’effet final est clair. Ainsi, on connaît le « pourquoi » de la machine (c’est-à-dire son objectif), mais on ne connaît pas le « comment » (la façon dont il va le réaliser).

Nous considérerons ici que les systèmes robotiques militaires doivent être « semi-autonomes », état défini selon les caractéristiques ci-dessus, avec de potentielles capacités d’apprentissage autonome et d’adaptation dynamique à l’environnement. Un système pleinement autonome sur le champ de bataille n’aurait en effet pas de sens pour l’action militaire, tant sur le plan tactique que sur le plan éthique, comme le démontre l’étude ci-dessous. Par facilité d’écriture, on regroupera dans le reste de cet article sous la notion de robots autonomes la qualification de robots semi-autonomes.

De l’utilité d’une machine avec une certaine forme d’autonomie pour le chef militaire

La ressource humaine se fait rare dans les armées occidentales affectées par la faiblesse numérique des classes d’âges les plus jeunes, la limitation des budgets (4), et surtout par le coût politique et médiatique des morts au combat. En conséquence, la préserver pour des tâches où elle est indispensable constitue une réelle valeur ajoutée pour les chefs militaires. La robotique militaire apporte cette capacité avec la possibilité de déléguer à des machines l’exécution de tâches subalternes mais néanmoins indispensables telles que les missions 3D (Dull, Dirty and Dangerous / ennuyeux, sale et dangereux). À titre d’exemple, la protection de nos soldats sera mieux assurée si des machines s’exposent au danger à leur place pour les missions de surveillance ou de patrouilles – très consommatrices en hommes et en temps – ou lorsqu’il faut analyser de grandes quantités d’images pour y déceler une potentielle intrusion ennemie.

Dans des milieux très difficiles d’accès ou en cas de perte de communication (comme le milieu sous-marin où les ondes de communication passent très mal), l’autonomie est aussi nécessaire à certains systèmes afin qu’ils puissent évoluer sans supervision humaine, son responsable ayant préalablement et par sécurité borné son autonomie à un certain espace et pour un temps donné. À titre d’exemple, la DARPA (5) travaille actuellement sur un prototype d’Unmanned Surface Vehicle (USV), le Sea Hunter : c’est un bâtiment de surface dédié à la lutte anti-sous-marine et capable d’évoluer en autonomie durant plusieurs mois, sur des milliers de kilomètres, sans équipage à bord, tout en respectant les règles de navigation internationales.

En outre, plus grande sera l’autonomie des systèmes robotiques qu’il mettra en œuvre, plus le soldat aura la possibilité de se concentrer sur sa mission en étant lui-même moins contraint par le contrôle de la machine, donc plus libre.

L’autonomie est de ce fait utile pour décharger les opérateurs des robots militaires de tâches dangereuses, fastidieuses ou répétitives sur le champ de bataille, ou pour assurer une meilleure réactivité face aux menaces ennemies.

La nécessaire place du chef

Le but de la guerre

La guerre, selon Clausewitz, est « le prolongement de la politique par d’autres moyens ». Elle vise à atteindre des objectifs, en principe clairement définis, fixés par l’autorité politique. Elle ne prend fin que lorsque les protagonistes sont revenus à une situation d’équilibre, c’est-à-dire quand les deux partis décident de mettre fin aux affrontements constatant que l’un s’affirme vainqueur et l’autre se reconnaît vaincu. Cette dialectique des volontés se vérifie par l’état de paix qui finit toujours par prévaloir. C’est en ce sens que les anciens constataient qu’Athéna, la force intelligente et stratégique, finit toujours par l’emporter sur Arès (6), la force brutale et désordonnée. Ainsi, la mission du chef consiste à user avec mesure des moyens à sa disposition pour hâter ce fameux retour à l’équilibre.

Le chef militaire dispose de moyens humains et matériels qu’il emploie selon une doctrine élaborée au regard des caractéristiques techniques de ses équipements, des aptitudes et compétences de ses subordonnés. Le robot autonome qui sera capable d’ouvrir un itinéraire piégé, d’acheminer la logistique sous le feu ou de renseigner en permanence et sans fatigue sur l’ennemi constitue une plus-value évidente et permettra sans nul doute l’économie de nombreuses vies humaines. Ce robot dénué d’affect et de tous les maux liés à la fatigue physique et psychologique du combattant sera un précieux auxiliaire. Pour autant, l’armement de drones soulève dès à présent des débats éthiques alors que ceux-ci sont en permanence sous contrôle de l’homme. La réflexion prend une acuité plus importante encore si l’homme est retiré de la boucle décisionnelle d’ouverture du feu.

Les principes de la guerre

Les principes français de la guerre ont été élaborés par le maréchal Foch alors qu’il enseignait à l’École de Guerre à partir de 1905. Aborder la place des systèmes robotiques autonomes dans l’action militaire, revient à revisiter ces trois principes à l’aune de leur autonomie.

Principe de la liberté d’action

C’est la possibilité pour un chef de mettre en œuvre ses moyens à tout moment et d’agir, malgré l’adversaire et les diverses contraintes imposées par le milieu et les circonstances, en vue d’atteindre le but assigné. Ce principe repose sur :

• La sûreté qui consiste à se protéger en fonction du risque estimé et/ou mesuré. La machine peut participer à ce principe, notamment en effectuant des calculs probabilistes de risques et en anticipant ainsi la réponse à apporter.

• La prévision, l’anticipation des événements et des actions adverses : les systèmes embarqués permettent d’offrir des capacités de calculs supérieures à l’homme pour explorer diverses options. L’autonomie de ces systèmes, notamment via l’IA, peut ainsi apporter une aide à la décision très utile au chef militaire en lui présentant différentes options et pourcentages de réussite ou de risques associés.

• La capacité de prendre l’ascendant et d’imposer sa volonté à l’adversaire : la machine même autonome n’ayant pas de volonté propre, nous avons ici typiquement le fruit d’un raisonnement qu’une machine seule ne peut effectuer, car pour une telle capacité il faut appréhender la situation globale, les opportunités de modifier la conduite de la manœuvre et les effets de l’action, ensemble de jugements qui sont du ressort de la décision du chef militaire.

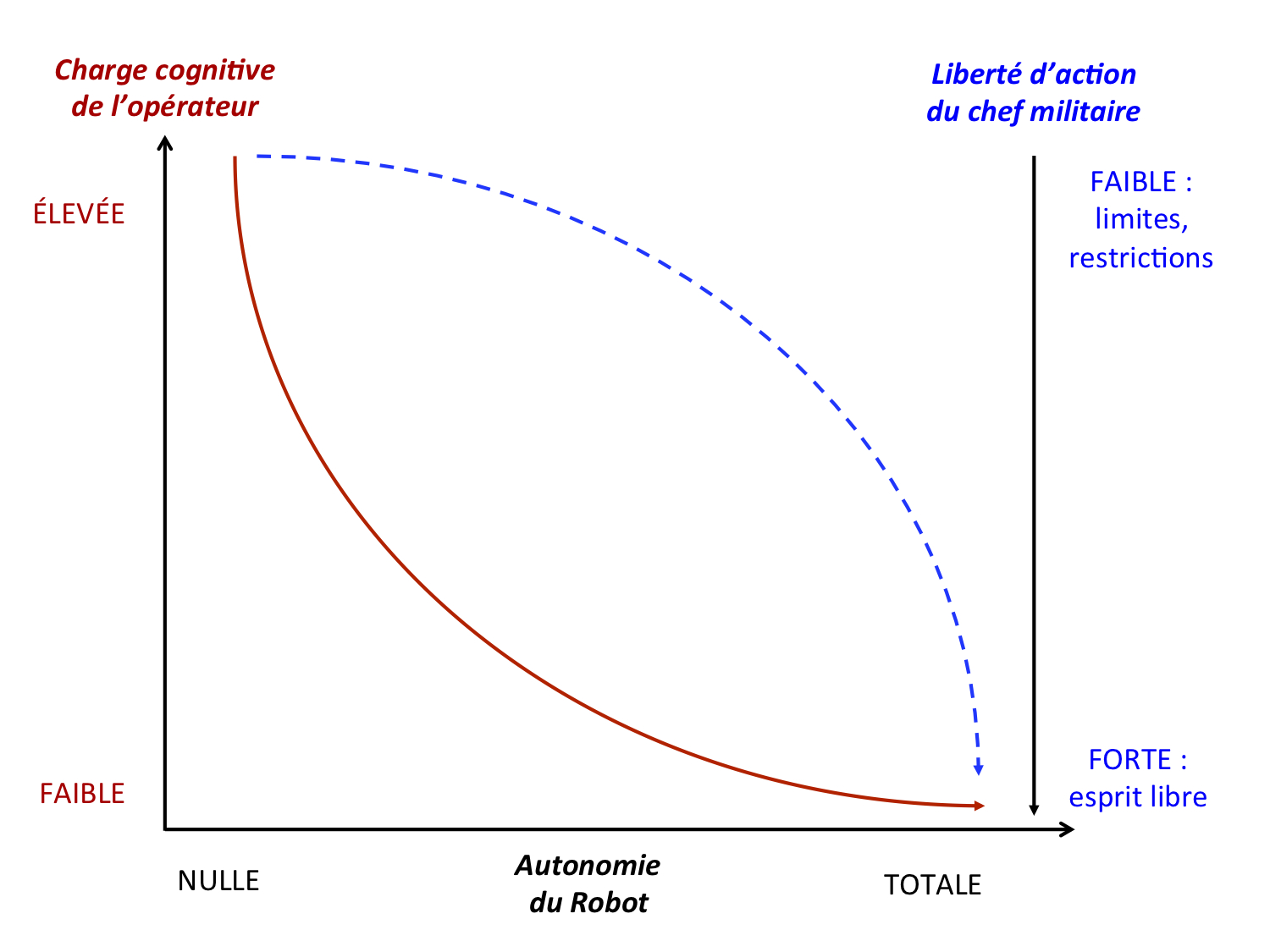

Figure 1 : Les effets de l’autonomie sur la charge cognitive et la liberté d’action

De plus, deux facteurs essentiels permettent au chef de conserver sa liberté d’action : une claire compréhension de l’adversaire et du milieu et l’audace.

Une machine ne pourra jamais comprendre les subtilités du cerveau humain, capable de simuler, de bluffer, de mentir et surtout d’aimer. A fortiori le cerveau d’un adversaire distant sur le champ de bataille. Tout au plus pourra-t-elle simuler. De même, l’audace restera toujours le propre de l’homme car elle intègre la notion de sacrifice nécessaire pour la mission ou pour sauver un camarade.

Enfin, la liberté d’action du combattant sera d’autant plus grande qu’il pourra déléguer à des systèmes des tâches ou des missions à effectuer en les laissant les réaliser sans son intervention, ce qui nécessite des robots ayant une certaine forme d’autonomie.

L’autonomie du robot constitue ainsi, à première vue, un gain substantiel de liberté d’action pour le chef militaire. Assurément, plus le système est autonome, plus grande est la liberté du combattant qui l’opère, et plus grande est la liberté du chef qui l’emploie. Une attention particulière devra cependant être portée aux conséquences politico-médiatiques opératives de cette liberté d’action de niveau tactique. En effet, la moindre « bavure » du robot autonome tactique pourra être lourde d’implications dans la conduite de la guerre aux niveaux opératifs et stratégiques.

La concentration des efforts

Le principe de concentration des efforts est « la nécessité de combiner les actions et d’optimiser les effets pour multiplier l’efficacité sur l’objectif choisi ». Or, l’avènement du combat collaboratif participe pleinement à ce principe, s’appuyant sur l’interconnexion des systèmes et l’échange en temps réel des informations tactiques. De plus, la réactivité de ces systèmes étant supérieure à celle de l’homme, une combinaison optimale des effets sera rendue possible par ces systèmes.

Ce principe indique cependant que « la supériorité relative est davantage la conséquence d’une lutte morale entre deux volontés que le choc physique entre deux masses ». À ce titre, seul l’homme montre des capacités de force morale et de résilience qui est son pendant. Néanmoins, la machine ne connaissant pas la peur et encore moins la notion d’abandon, ne se rendra jamais tant qu’une certaine forme d’autonomie lui sera conservée.

L’économie des moyens

Le troisième principe est celui d’économie des moyens correspondant à une répartition et application judicieuse des moyens en vue d’obtenir le meilleur rapport capacités/effets pour atteindre le but assigné.

La machine peut participer à ce principe. L’interconnexion des systèmes sur le champ de bataille leur permettra d’avoir une connaissance précise de l’état de chacun des systèmes déployés ou en réserve, et de répartir les ressources de façon optimale. Le cas de l’essaim de robots en déploiement pour couvrir une zone par ses caméras est très représentatif à cet égard. Mais c’est le choix du chef, « son expression claire et précise pour atteindre un objectif », qui détermine la mise en œuvre efficace de ce principe : en consentant aux risques liés à l’audace, il va décider de l’affectation correcte des moyens à sa disposition puis anticiper et percevoir les effets de son action.

Cet article tente ici de démontrer que, malgré les possibilités de réactivité décisionnelle que peuvent apporter l’IA et ses capacités de planification, il paraît inconcevable d’imaginer comment une machine pourrait appréhender et mettre en balance la valeur des vies humaines engagées, l’impératif de la mission, l’acceptation de la manœuvre par les hommes qui l’exécutent, et les capacités de réaction de l’ennemi, en un mot « sentir » le champ de bataille.

La guerre est un affrontement des volontés

Selon André Beauffre, « la lutte des volontés se ramène donc à une lutte pour la liberté d’action, chacun cherchant à la conserver et à en priver l’adversaire » (7). Les machines n’ont pas et n’auront jamais de volonté propre, elles ne sont que des algorithmes réagissant à des stimulis (capteurs notamment) et s’adaptant à la situation par l’écoute de leurs capteurs et le traitement de l’information qui en suivra. On ne pourra donc pas parler de volonté des algorithmes, mais éventuellement d’une volonté humaine « algorithmisée » dans une machine.

De même, toute lutte des volontés passe par une discipline intellectuelle où la machine peut être docile et suivre les instructions et le cadre qui lui ont été donnés, mais également par une discipline que l’on pourrait qualifier d’intelligente et active, c’est-à-dire qui comprend l’esprit de la mission et peut faire preuve d’initiative, notamment lorsqu’il faut transcrire en actes la lettre de la mission. L’initiative est possible pour une machine si les règles du jeu lui sont bien spécifiées et si elles restent constamment les mêmes. Or dans la conduite de la guerre l’ennemi ruse, se dissimule, etc., et tend à surprendre l’ennemi par des changements de tactique. La machine ne pourra certainement pas comprendre le jeu ennemi et adapter l’exécution de la mission en conséquence. C’est le rôle et la responsabilité du chef qui doit être capable d’appréhender l’ensemble d’une situation.

La responsabilité du chef

La dialectique entre un chef et ses hommes repose sur cette notion de responsabilité de laquelle découlent discipline et loyauté, indispensables à la cohérence, à l’efficacité opérationnelle et, in fine, à la victoire.

Or, la discipline relevant de l’intelligence et de loyauté du cœur, le chef pourra-t-il se passer de son semblable dans la conception et la conduite de la guerre ? Le robot aussi perfectionné soit-il relève de la matière pure et non de l’esprit. Sa faculté à imiter à la perfection les comportements humains se heurtera toujours à la barrière de l’innovation, de l’imagination, de l’inédit. Discipline et loyauté sont indissociables de la notion de liberté, capacité de l’être à choisir ou non ce qu’il considère être le Bien et à en assumer les conséquences. Or, quel libre arbitre pour un amas de métal et de diodes sinon celui que son concepteur et son instructeur auront bien voulu modéliser dans son cerveau artificiel ?

Selon les modes d’action choisis par le chef dans la conduite du conflit, l’effet final recherché, qui en principe doit permettre d’obtenir la paix, est atteint de manière plus ou moins rapide avec des dommages plus ou moins importants. Or, les procès qui ont suivi de nombreux conflits depuis Nuremberg démontrent que la responsabilité juridique et morale des chefs politiques et militaires est de plus en plus systématiquement invoquée. Petit à petit, la mise en cause morale et juridique glisse vers les échelons les plus bas de la hiérarchie et l’inculpation de crime de guerre peut concerner le fameux « caporal stratégique » du général Krulak (8). Les robots passeront-ils un jour devant la Cour pénale internationale ?

La nécessité d’un chef qui donne du sens à l’action militaire

Les récents conflits au Proche-Orient attestent de ce que la victoire militaire ne peut être la seule condition d’un retour à la paix, a fortiori quand le vaincu refuse sa défaite faute d’avoir pu combattre équitablement. Partant de ce constat, le général de corps d’armée Yakovlev infère que l’utilisation du robot par un chef permettra de réhumaniser des conflits dans lesquels Athéna ne parvient plus à vaincre Arès (9). En effet, les historiens montrent que la Première Guerre mondiale a atteint son paroxysme au moment où chacun des adversaires, considérant le poids de ses morts, ne pouvait plus concevoir de paix sans l’anéantissement de l’ennemi. On pourrait imaginer qu’une lutte à distance et par robots interposés favoriserait un retour à la symétrie sans laquelle la paix ne saurait être durable. On se plaît ainsi à imaginer un robot dépourvu d’affect qui ne puisse jamais reproduire les travers de Patrocle (10), ami d’Achille. Ce dernier, victime de son hubris, dépasse les bornes en semant la mort de manière outrancière dans les rangs troyens, en dépit des sages conseils de pondération d’Achille.

Pour qu’Athéna puisse s’imposer, il est indispensable de distinguer ce qui permettra aux belligérants de trouver, à l’issue des combats, un chemin de retour vers la paix. Les conflits du XXe siècle, empreints d’idéologies élaborées au cours du siècle précédent, constituent un tournant dans l’Histoire car, en sus d’une industrialisation de la guerre, ils comportent un moteur idéologique très important désormais relayé par des médias puissants. La guerre, autrefois politico-militaire, est devenue totale, c’est-à-dire qu’elle inclut désormais l’ensemble de la société. Aujourd’hui, dans un monde où la masse d’informations, de biens, de capitaux et de personnes s’échange instantanément, les idées se confrontent en permanence avec violence. La conflictualité se nourrit de ces affrontements idéologiques, entretient Arès et relègue momentanément l’ONU à un rôle de spectatrice. Loin des considérations de Fukuyama au sujet de la fin de l’histoire (11), le modèle des démocraties libérales ne s’impose pas, bien au contraire. Malgré leurs armements les plus sophistiqués, elles ne vainquent pas un ennemi impuissant mais bien décidé à poursuivre le combat sous d’autres formes afin qu’advienne la justice dont il s’estime lésé.

Le retour à la paix implique un règlement du conflit entre belligérants qui se respectent. Le colonel Lecointre écrivait ainsi : « C’est certainement le sacrifice consenti de sa propre vie qui rend moralement supportable l’obligation de tuer. La mort doit être donnée le moins possible dès lors qu’existe une sorte de symétrie déontologique entre la vie d’un ennemi et celle d’un ami. De cette symétrie découle une vertu essentielle du soldat : la capacité de maîtriser sa propre violence. » (12). Plus que jamais, le chef militaire prend une part importante de l’affrontement idéologique car il porte, par ses décisions, la responsabilité du jus in bello si étroitement dépendant du jus ad bellum et, in fine, du retour à la paix.

Finalement, au-delà de la tactique, la stratégie est de plus en plus tributaire de son impact sur l’intelligence et le cœur des populations, véritable enjeu des guerres contemporaines. La question de fond est liée à l’ensemble des valeurs invoquées et vécues par les belligérants, et au prix qu’ils sont prêts à payer pour les promouvoir. Actuellement, la religion constitue une part importante du jus ad bellum de Daech qui profite de la sécularisation assumée des démocraties libérales. Pour les sociétés postmodernes cette dimension n’est qu’un prétexte. Or, refuser d’entrer dans la dialectique religieuse, c’est ignorer que des hommes et des femmes sont déterminés à mourir pour leur religion et, a contrario, c’est empêcher le combattant de son camp de s’interroger sur les raisons justifiant le propre don de sa vie. Le sacrifice du colonel Arnaud Beltrame, lors de l’attaque terroriste de Trèbes le 23 mars 2018, éclaire cette dissymétrie. Nombreux ont été les articles qui s’interrogeaient sur le parcours de ce héros et les raisons qui avaient pu le pousser à un tel sacrifice. Cette démarche est pourtant autant individuelle que collective et prend une part importante dans la préparation opérationnelle. Elle relève de cet « esprit guerrier » que le général d’armée Bosser appelle à développer (13) précisément au moment où l’armée de Terre déploie le système Scorpion.

La crédibilité d’un chef en opération repose sur son aptitude à exercer une autorité qui, conformément à l’étymologie du terme, fait grandir ses subordonnés individuellement et collectivement. Par sa parole et ses décisions, par son exemplarité, il participe, dès l’instruction, à l’éducation de leur conscience. Ainsi, au moment de l’engagement, il transmet à ses subordonnés le sens qu’il donne à la mission, en justifie le prix à payer en usant du minimum de la force pour la remplir.

Le robot semi-autonome constitue un outil indispensable au chef militaire. Mais il lui revient de donner le sens de la mission et de sa mise en œuvre. Ce subtil distinguo entre l’esprit et la lettre relève de l’intuition qui est une dimension purement humaine. Pour parodier le maréchal Lyautey, le Sala saura-t-il éviter la destruction d’un marché villageois, si important pour la conquête des cœurs d’une population (principal enjeu des conflits) ? En d’autres termes, ce robot disposera-t-il un jour d’un cœur pour gagner les cœurs et les esprits ?

Une responsabilité humaine quel que soit le degré d’autonomie du système

La guerre, dialectique des volontés, peut aisément se concevoir par robots interposés et l’on se plaît à imaginer nos Sala en « géants de fer » (cf. film d’animation de Brad Bird, produit en 1999) « capables de se sacrifier pour sauver l’humanité ». En ce sens, l’avènement des robots autonomes, permettant d’épargner des vies humaines, serait un progrès dans la conduite de la guerre. Mais qu’adviendra-t-il lorsqu’un robot tueur supprimera des êtres humains ? Ou pire, s’il fait des victimes innocentes dans la population civile sans qu’apparemment un homme n’ait déclenché la frappe ? Si certains envisagent sérieusement la responsabilité juridique du robot dans certaines régions du globe (14), elle entre en contradiction avec la conception de la responsabilité dans nos sociétés occidentales. La responsabilité dans l’emploi de ce robot, quel que soit son degré d’autonomie, sera toujours celle de son concepteur ou de son employeur. Dès lors, il est essentiel que le chef militaire, commandant à des robots autonomes, conserve en permanence le contrôle de l’apprentissage et de la restitution des savoir-faire et réactions attendues des machines dont il a le commandement.

La responsabilité, au moins juridique, doit être envisagée sur le plan légal depuis le bureau d’étude concevant le robot autonome jusqu’à son servant sur le champ de bataille. Il importe, en effet, d’impliquer tant juridiquement que moralement tous les protagonistes. Dans le prolongement, il est indispensable de suivre, étape par étape, le processus de programmation des robots autonomes de manière à pouvoir identifier en permanence chacun des protagonistes intervenant dans leur entraînement et à déterminer leur degré d’implication pénale en cas de dysfonctionnement.

Dans une vision anthropologique traditionnelle, on considère l’homme comme un corps, une psychologie et une âme capable de transcendance. Son intelligence sera donc la résultante d’une approche métaphysique d’une réalité perceptible par les sens et le psychisme. Un robot pourra probablement imiter avec une extrême finesse les comportements humains. Cependant, si « intelligent » soit-il, il n’aura jamais accès à la transcendance propre au genre humain. Or, ce que l’on appelle les « forces morales » revêt un caractère essentiel dans la dialectique des volontés. L’histoire de France ne manque pas d’exemples stratégiques (Jeanne d’Arc mobilisant Charles VII et ses ducs) ou tactiques (Bonaparte sur le pont d’Arcole) pour illustrer ce supplément d’âme que le chef confère à ses subordonnés pour galvaniser leurs énergies et emporter la victoire.

L’homme restera donc l’élément clef de la conflictualité et le robot, si autonome soit-il, devra rester sous son contrôle tant dans l’engagement opérationnel que dans sa préparation afin d’éviter qu’Arès, ici matérialisé par les Sala, prenne le dessus et ne finisse par se dévorer lui-même en entraînant la perte de ses utilisateurs et inventeurs. La science-fiction a d’ailleurs largement exploré ce thème dans de nombreux films dont Terminator (1984) est l’un des plus connus. La formation des chefs militaires et des décideurs politiques devra s’adapter pour s’armer face aux enjeux techniques, stratégiques et éthiques liés à l’emploi des robots autonomes dans la guerre.

Un robot sous contrôle

Une subsidiarité sous contrôle

Tout chef militaire doit maîtriser l’action militaire qu’il met en œuvre, et pour cela doit pouvoir contrôler les moyens dont il dispose. Le chef commande aux unités qu’il a sous les ordres. Il leur fait également confiance dans l’exécution de la mission qu’il leur confie, ce qui fonde le principe de subsidiarité.

Pour cette raison, il n’est pour lui d’aucun intérêt d’avoir un système robotique qui se gouverne avec ses propres règles et ses propres objectifs, ni qui puisse faire preuve de désobéissance ou s’affranchir du cadre qu’on lui a fixé. De même, un tel système doit respecter les ordres et les consignes militaires, car c’est le chef qui les donne et qui donne du sens à l’action militaire, tout en étant le responsable. La conséquence est, qu’à tout moment, le chef doit pouvoir reprendre la main sur un système robotique et potentiellement lui faire quitter le « mode autonomie » dans lequel il l’avait lui-même autorisé à entrer.

En revanche, si l’on fait sienne la célèbre expression de Georges Clemenceau « La guerre ! C’est une chose trop grave pour la confier à des militaires », un risque serait de voir le décideur politique prendre directement le contrôle de ces robots, s’il trouve que les considérations éthiques de son chef militaire nuisent à l’efficacité. Par ailleurs, la tentation peut être grande pour le politique de substituer à l’engagement d’un soldat (de condition mortelle) celui de systèmes robotisés, avec pour conséquence une banalisation de l’usage de la force dans les relations internationales. D’autant plus que leur utilisation n’exonère ni l’opérateur, ni le chef de leur responsabilité. Ils sont les garants de leur utilisation. Cette contrainte aura pour effet vertueux d’introduire une obligation de prudence pour le décideur dans l’utilisation de sa machine et lui évitera de l’utiliser de façon dangereuse ou d’une façon qui irait à l’encontre du droit de la guerre.

L’autonomie est donc utile pour des systèmes déployés sur le terrain, à condition néanmoins qu’ils restent des exécutants au même titre que tout élément tactique et qu’ils puissent être soumis aux ordres, aux contre-ordres et à l’exigence du rapport.

La question que pose l’Intelligence artificielle (IA)

La vraie question concerne l’IA, dont Stephen Hawking indiquait pour sa part en 2016 « qu’elle pourrait développer sa propre volonté, en conflit avec la nôtre » (15).

Offrant des capacités de traitement de l’information supérieure à celles de l’homme, elle pourra tester des combinatoires multiples pour un effet particulier, offrir une aide décisionnelle au chef militaire, voire aller jusqu’à effectuer des missions par elle-même si le chef militaire accepte de la lui déléguer (missions d’interdiction de zone, de dépollution de zone).

En restreignant l’autonomie à une semi-autonomie comme expliqué ci-dessus, reste la question du contrôle de systèmes auto-apprenants. En fait, tout système auto-apprenant doit être éduqué. Aussi, comme les propriétaires d’animaux sont responsables du dressage de ces derniers et des éventuels dégâts qu’ils pourraient commettre, le chef militaire sera responsable du bon apprentissage et de la bonne utilisation de sa machine sur le terrain. Pour ce faire, il devra superviser l’apprentissage précédant l’autonomie, puis sa mise à jour régulière, et s’assurer de son contrôle dans le temps.

Des Systèmes d’armes létaux autonomes (Sala) mais sous contrôle

La question fondamentale et la plus ultime concerne l’autonomie dans la décision de tir, comme le met fortement en lumière la lettre ouverte sur l’interdiction des armes autonomes signée en 2015 par Stephen Hawking, Elon Musk et Steve Wozniak (16) qui met en garde contre les dangers de l’utilisation dans le champ militaire des technologies liées à l’IA et s’inquiète de la possible prolifération des armes autonomes.

Le Parlement européen suit d’ailleurs cette recommandation en demandant, le 12 septembre 2018, la mise en place d’un instrument juridiquement contraignant interdisant les Sala (17), en totale opposition avec les grandes puissances mondiales telles que les États-Unis, la Russie, la Chine et Israël qui développent de tels systèmes (18).

Pourtant, il apparaît inéluctable que des Systèmes d’armes létaux semi-autonomes, que nous requalifieront ici en Salsa, verront le jour dans les prochaines décennies car ils offrent tout simplement sur le plan défensif une meilleure réactivité que l’homme, de pouvoir rester en permanence sur zone 24h/24, ainsi que de pouvoir faire face à des attaques saturantes, comme l’expose Gérard de Boisboissel dans son article (p. 45-55).

Pour illustrer ces caractéristiques, on peut imaginer un système antimissile autonome patrouillant autour d’une zone à défendre, faisant face à un tir soudain de plusieurs missiles ennemis. Face à une telle menace imminente et saturante, le chef militaire ne peut assurer une totale maîtrise et une coordination de l’action létale. Ce Salsa permettra la réactivité nécessaire, pouvant s’appuyer même sur une intelligence artificielle embarquée calculant les trajectoires des missiles et sélectionnant ceux à abattre en priorité.

Mais comme précisé ci-dessus, un Salsa ne devra passer en mode « tir semi-autonome » que sur décision d’un opérateur humain, à savoir un décideur militaire formé à ces questions, probablement un officier ou un groupe d’officiers spécialement formés. Ainsi, c’est cet opérateur qui configurera la machine et activera l’autonomie de la fonction létale (mais avec la possibilité d’en reprendre le contrôle lorsqu’il le souhaite) en fonction de sa connaissance de la menace, des règles et du milieu d’engagement ainsi que de la situation tactique et engagera sa responsabilité. Comme garde-fou, l’utilisation d’un Salsa devra être bornée dans le temps et bornée dans l’espace. On devra pouvoir également désactiver le mode « tir semi-autonome » à tout moment, ce qui implique une communication constante avec l’opérateur.

* * *

Le robot autonome insensible à la fatigue intellectuelle et physique ainsi qu’aux fortes charges émotionnelles peut assister le chef militaire en lui fournissant, en permanence et de manière autonome, le renseignement dont il aura besoin, en le soulageant de tâches secondaires ou en réalisant des missions de sauvegarde. Cette contribution importante demandera cependant une phase d’apprentissage qui monopolisera, avant l’engagement, une grande partie de sa disponibilité.

Au-delà des spécifications techniques à imposer aux concepteurs de robots autonomes pour conserver un contrôle permanent et la traçabilité du processus d’apprentissage de ces machines, le chef devra disposer des compétences techniques nécessaires pour instruire, entraîner et contrôler son robot autonome. Ce n’est rien moins que sa responsabilité tant morale que juridique qui est en jeu. Or, si nul n’est censé ignorer la loi, la conscience du décideur doit être nourrie de science pour prendre la mesure des enjeux dont il est ici question et assumer la responsabilité juridique et morale de leurs auxiliaires-robotiques dans le jus in bello. Il n’y aurait en effet rien de plus dangereux que de laisser l’ingénieur concepteur décider seul des normes techniques de construction et du suivi de l’apprentissage de sa « créature ». En effet, le degré d’autonomie du robot sera fixé par le chef à l’aune de sa propre responsabilité. En d’autres termes, c’est le degré de fiabilité que le chef militaire reconnaît à son auxiliaire-robotique qui conditionne le niveau d’autonomie. On retrouve alors le paradigme de la confiance et de la loyauté si important dans les rapports de commandement. Cependant, si une part de la responsabilité peut être assumée par des subordonnés humains disposant d’un véritable libre arbitre, la délégation de responsabilité d’ouverture du feu à un robot amas de métaux et de câbles, n’exonérera en rien le chef militaire.

Par ailleurs, lorsque le soldat sur le champ de bataille appuie sur la détente de son arme, il a d’autant plus conscience de l’acte qu’il pose, qu’il met lui-même sa vie en jeu. Or, les modes d’action « stand off » consistant à frapper à distance, hors de portée de l’ennemi, ont eu pour impact de désinhiber leurs tenants et ont largement accru les dégâts matériels et humains de la guerre avec les effets que l’on connaît en termes d’asymétrie et de modes d’action terroristes. La désinhibition du chef militaire n’est-elle pas potentiellement plus grande encore s’il prétend n’avoir pas voulu ce que le robot a « décidé » et s’il s’exonère du « comportement » de son auxiliaire en raison de sa fameuse autonomie (19) ? C’est pour cette raison fondamentale que l’on peut avancer que l’avènement du robot autonome exigera un ancrage anthropologique encore bien plus fort du chef militaire.

Cet ancrage repose sur une formation humaine densifiée et particulièrement exigeante dans les domaines métaphysiques et philosophiques (retour aux humanités) afin de conférer au chef militaire une autonomie de pensée et des repères moraux indispensables pour décider et agir dans l’urgence. Cette formation humaine s’appuyant sur les trois dimensions constitutives de la personne (corps, psychisme et âme) devra, plus que jamais, lui permettre de discerner dans la complexité, pour décider dans l’incertitude afin d’agir dans l’adversité.

Discerner dans la complexité revient à inculquer à l’officier des repères moraux solides dans un monde qui s’est brutalement rétréci sous l’effet de l’accélération des échanges culturels, économiques, financiers tout comme la circulation de l’information en temps réel. En effet, si l’interaction entre chef et subordonnés facilite son discernement, celui-ci ne sera plus possible avec un robot autonome. Il accroîtra d’autant l’isolement d’un chef potentiellement esseulé sur le champ de bataille avec l’avènement de la guerre infocentrée et ses conséquences décrites dans les « perspectives tactiques » du général Guy Hubin (20). La compréhension des opérations dans leur contexte politique devenue un enjeu tactique, exige des jeunes chefs de section voire du « caporal stratégique » une exécution particulièrement fine et délicate de ses missions. Dans ce cadre, la décision d’emploi ou non d’un robot autonome et, plus encore, les règles d’engagement que ce chef tactique donnera à son auxiliaire-robotique peuvent être lourdes de conséquences. La connaissance du milieu dans lequel il opère, de la situation culturelle, politique et sociale, est un prérequi indispensable qui milite pour que la formation professionnelle du chef militaire soit aussi solide dans le domaine tactique que dans les domaines académique et éthique.

Pour agir dans l’adversité, le chef militaire, certes allégé d’une part de fatigue physique, morale et cognitive assumée par le robot, devra néanmoins supporter une charge de responsabilité très supérieure à celle qu’il aurait eue dans le commandement d’êtres humains dotés de libre arbitre donc potentiellement responsables. Le travail des robots autonomes restant sous la responsabilité juridique et morale du chef militaire, celui-ci, devra être capable d’en contrôler les actes en permanence. Ici, le principe de précaution s’applique à la chose militaire. Il n’y a apparemment rien de très nouveau dans la mesure où l’usage d’armes de destruction massive a déjà donné lieu à de nombreuses et solides spéculations intellectuelles et éthiques. Cependant, l’autonomie du robot rend la question éthique bien plus délicate. La formation des chefs passera donc également par un retour aux humanités, à une « philosophie opérationnelle » afin de leur donner la sagesse indispensable à l’usage du robot autonome, dès son instruction. En d’autres termes, « tel robot, tel maître » est un appel au travail de l’homme sur lui-même afin que l’hubris du maître ne gagne sa machine.

Dans L’obsolescence de l’homme (21), Gunther Anders estime que l’homme serait actuellement en train de créer un monde technologique (dont nos robots font partie) qui, au final, l’humilie et le rend honteux. En effet, les machines qu’il élabore sont plus performantes que lui dans l’emploi qui leur est destiné. L’erreur devient forcément humaine. Cette situation est inédite parce qu’avec les potentialités offertes par l’IA, de la place dont il disposait jusqu’alors au sommet de la création, l’homme, dominé par les idoles technologiques, pourrait se voir réduit au rôle de maillon faible d’un système qu’il a pourtant créé. Il est donc grand temps de réfléchir à l’impact du progrès technologique afin d’éviter que l’homme, victime de sa démesure, ne perde confiance en lui-même et en ses inventions. L’enjeu du recours aux systèmes d’armes robotisés autonomes est donc avant tout éthique et dépend de la vision anthropologique de ses concepteurs, de ses utilisateurs et du législateur. En définitive, la formation humaine de ces protagonistes est aujourd’hui une urgence car le déploiement de ces « nouveaux combattants » est imminent. À côté des belles promesses environnant l’usage de robots autonomes, se révèlent des dangers importants pour les hommes. La nouvelle éthique de responsabilité de Hans Jonas (22) mise en œuvre avec discernement permettra d’accompagner cette évolution pour en limiter les effets les plus délétères. En cela, le chef militaire aura, aux côtés des experts, un avis éclairé à proposer au législateur, pourvu qu’il soit formé. ♦

(1) CICDE, Concept exploratoire interarmées CEIA-3.0.2_I.A.&SYST-AUT(2018), N° 75/ARM/CICDE/NP, 19 juillet 2018, p. 8 et 10. Disponible sur Intradef (http://portail-cicde.intradef.gouv.fr).

(2) Définition Otan de MCDC (Multinational Capability Development Campaign) : « A system’s capacity to act under supervision of human programming, according to desired goals, precepts, internal states, and knowledge, without outside intervention » : Combined Joint Operations from the Sea Centre of Excellence, Maritime Unmanned Systems in ASW, collaborative ASW, 25 février 2018 (www.cjoscoe.org/) p. 5.

(3) Tâches similaires à celles de haut niveau du système télésupervisé, incluant notamment les tâches conduisant au démarrage et à l’arrêt des effecteurs mais n’incluant plus celles de déclenchement et de cessation des effecteurs.

(4) « L’Armée de terre tient dans le Stade de France : 80 000 dans les gradins, le reste sur la pelouse », général d’armée Elrick Irastorza, 18 octobre 2012 à Montpellier.

(5) Defense Advanced Research Projects Agency, agence du département de la Défense des États-Unis chargée de la recherche et développement.

(6) Holeindre Jean-Vincent, La ruse et la force. Une autre histoire de la stratégie, Éditions Perrin, 2017 ; p. 35.

(7) Beaufre André, Introduction à la stratégie, 1963.

(8) Krulak Charles C., « The Strategic Corporal: Leadership in the Three Block War », Marine Corps Gazette, vol. 88 n° 1, janvier 1999 (www.au.af.mil/au/awc/awcgate/usmc/strategic_corporal.htm).

(9) Yakovleff Michel, « Allocution lors du colloque “Legal & Ethics by design” », École militaire de Paris, 6 février 2018.

(10) Homère, L’Iliade, XVI, 674-709, Folio classique, p. 344.

(11) Fukuyama Francis, The End of History and the Last Man, 1992.

(12) Lecointre François, « Pour une culture armée », Inflexions, n° 11, juin-sepembre 2009, p. 30-40

(http://inflexions.net/articles/pour-une-culture-armee-2).

(13) Cf. Merchet Jean-Dominique, « Armée de terre : le général Bosser exalte “l’esprit guerrier” », Secret Défense, 4 octobre 2018 (www.lopinion.fr/blog/secret-defense/).

(14) Cf. Neuer Laurence, « Alain Bensoussan : “Il faut construire un droit spécifique aux robots” », Le Point, 20 novembre 2017 (www.lepoint.fr/).

(15) Hawking Stephen, cérémonie d’ouverture du Leverhulme Centre for the Future of Intelligence, 19 octobre 2016 (www.cam.ac.uk/).

(16) Newsroom, « Une lettre ouverte contre les systèmes d’armes autonomes », H+, 28 juillet 2015 (https://humanoides.fr/).

(17) « 3. demande à la vice-présidente / haute représentante, aux États membres et au Conseil d’œuvrer au lancement de négociations internationales pour un instrument juridiquement contraignant qui interdise les systèmes d’armes létaux autonomes ;

4. souligne, dès lors, qu’il est extrêmement important d’empêcher la mise au point et la production de tout système d’armes létal autonome dont les fonctions critiques, telles que le choix et l’attaque des cibles, sont dénuées de contrôle humain ; ». Proposition de résolution commune, 10 septembre 2018 (www.europarl.europa.eu/).

(18) Le 10 juillet 2017, l’entreprise russe Kalachnikov communique sur son programme de développement de modules armés autonomes s’appuyant sur des réseaux de neurones pour la détection, l’identification et le traitement automatique des cibles.

(19) Les témoignages d’opérateurs de drones (robots pas encore autonomes) en provenance des États-Unis sont particulièrement éclairants : la blessure invisible (syndrome post-traumatique) ne les épargne pas et a des effets d’autant plus dévastateurs que ces « combattants » à distance ne risquent peut-être pas leur vie physique mais sans doute leur santé psychique. Un chef militaire devra être préparé à ce type de blessure car la traçabilité de formation et d’agir du robot autonome, indispensable à la mise en œuvre de sa responsabilité, permettra d’établir, y compris en images, un bilan des pertes dont il devra assumer le poids moral.

(20) Hubin Guy, Perspectives tactiques (3e édition), Économica, 2009, 192 pages.

(21) L’Obsolescence de l’homme. Tome II : Sur la destruction de la vie à l’époque de la 3e révolution industrielle (publication originale en allemand, 1980).

(22) Jonas Hans, Le Principe Responsabilité : une éthique pour la civilisation technologique, 1991 (publication originale en allemand, 1979).

_astronaut_Sophie_Adenot_(jsc2025e058846_alt).jpg)