L’introduction dans la vie courante de robots et de systèmes autonomes dotés d’intelligence artificielle fait l’objet d’une médiatisation accélérée et de débats sur les dilemmes éthiques. Cet article analyse différents aspects contextuels et dynamiques de l’usage de véhicules autonomes, et propose des pistes de travail spécifiques et des recommandations en vue de l’élaboration d’une « politique éthique du véhicule autonome » à l’ensemble des acteurs concernés de la filière automobile.

Peut-on élaborer une politique éthique du véhicule autonome ?

Contexte et enjeux

Médiatisation des véhicules autonomes et des dilemmes en cas d’accident

La commercialisation de la Voiture autonome (VA) par tous les grands constructeurs automobiles est imminente et fait l’objet d’une grande couverture médiatique. Déjà un nouveau constructeur comme Tesla a introduit un mode de pilotage automatique dans ses véhicules électriques, tandis que Waymo (groupe Alphabet, la maison mère de Google), Apple ou Uber font miroiter le déploiement rapide de véhicules sans conducteur.

Les arguments mis en avant pour promouvoir la conduite autonome sont de quatre types :

• Améliorer la sécurité, en arguant du fait que 90 % des accidents de la route sont dus à des erreurs humaines qu’une voiture autonome pourrait éviter à l’avenir (1).

• Donner du temps libre au conducteur pour travailler, se distraire ou se reposer pendant un trajet en mode automatique.

• Optimiser l’utilisation du parc automobile et la fluidité du trafic, et donc le bilan carbone de la mobilité.

• Rendre accessible la mobilité à des personnes à mobilité réduite et leur offrir de nouveaux services en zones peu denses ou dans certains créneaux horaires, là – ou lorsque – les transports publics traditionnels ne peuvent assurer un service optimal.

Cependant, de nombreux problèmes techniques doivent encore être surmontés avant un déploiement sans restriction de la conduite autonome. De récents incidents de circulation aux États-Unis impliquant des voitures autonomes (Tesla, Uber) ont mis en évidence des défauts de perception, de prise de décision et de contrôle. Ils ont aussi soulevé des questions juridiques quant à la responsabilité en cas d’accident ? Aux questions d’ordres technique et juridique se greffent des questions d’ordre éthique et politique, et des questions d’acceptabilité sociale de ce type de véhicules.

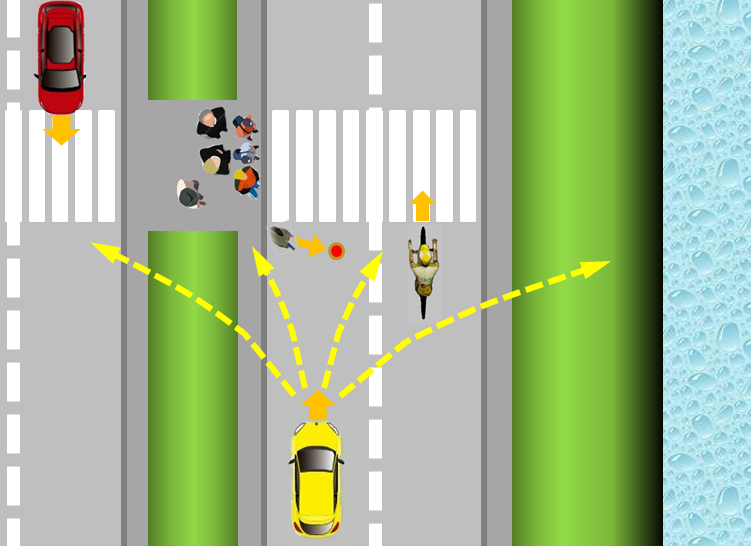

Figure 1 : Illustration schématique d’une situation où un véhicule autonome – en jaune – devra choisir entre différentes trajectoires comportant toutes des risques pour les autres usagers de la route ou pour lui-même alors qu’un enfant traverse soudainement la route devant lui à la poursuite d’un ballon.

Le cas extrême, rare mais pas improbable, est celui où une voiture autonome se trouverait dans une situation telle que sa réaction engagerait inévitablement le pronostic vital ou un risque majeur, soit pour les usagers de la voiture, soit d’autres usagers de la route, comme illustré par exemple dans la Figure 1. Laquelle de ces populations la voiture autonome devrait-elle protéger prioritairement ? En l’occurrence ce n’est pas le VA qui choisira, mais des concepteurs humains qui auront introduit dans les algorithmes qui pilotent la voiture, les critères d’après lesquels elle déterminera son comportement en faveur d’une orientation ou d’une autre. Mais qui dispose de la légitimité pour déterminer ces critères ? Quels seraient-ils et comment les justifier ?

Il est nécessaire de se pencher sur ces questions et d’anticiper les réponses à y apporter, en particulier vis-à-vis des médias et des pouvoirs publics, pour éviter de mauvais procès tel que celui auquel Mercedes a été confronté début octobre 2016. À un porte-parole de Mercedes qui avait dit que ses véhicules autonomes donneraient systématiquement la priorité à ses occupants, un journaliste américain a réagi dans un article au titre très violent (2).

Problématique éthique de la robotique et de l’Intelligence artificielle (IA)

Compte tenu de l’essor de la robotique associée à l’IA dans de nombreux secteurs d’activité, le thème de l’éthique de la robotique et de l’IA mobilise plusieurs équipes de recherche d’universités dont nous ne pouvons donner ici qu’un aperçu limité (3), et il soulève des questions de première importance au plan philosophique à plusieurs niveaux :

• les enjeux anthropologiques et sociaux de l’introduction de la robotique et de l’IA ;

• les notions d’autonomie, d’imitation, de ressemblance, de partage d’émotions, voire d’empathie pour une machine en relation avec des êtres humains ;

• la possibilité de coder numériquement l’éthique et de faire réagir l’algorithme d’IA d’un système autonome conformément à l’éthique du point de vue humain et sur la possibilité d’établir une échelle ou une métrique de « valorisation éthique » pour un agent moral artificiel tel qu’un robot.

C’est ce dernier niveau d’éthique appliquée et opérationnelle qu’on peut appeler « éthique artificielle » par analogie avec l’IA qui nous intéresse plus particulièrement ici.

Dilemmes éthiques, casuistique rationnelle, sociologie des réactions

et recherche d’un compromis acceptable

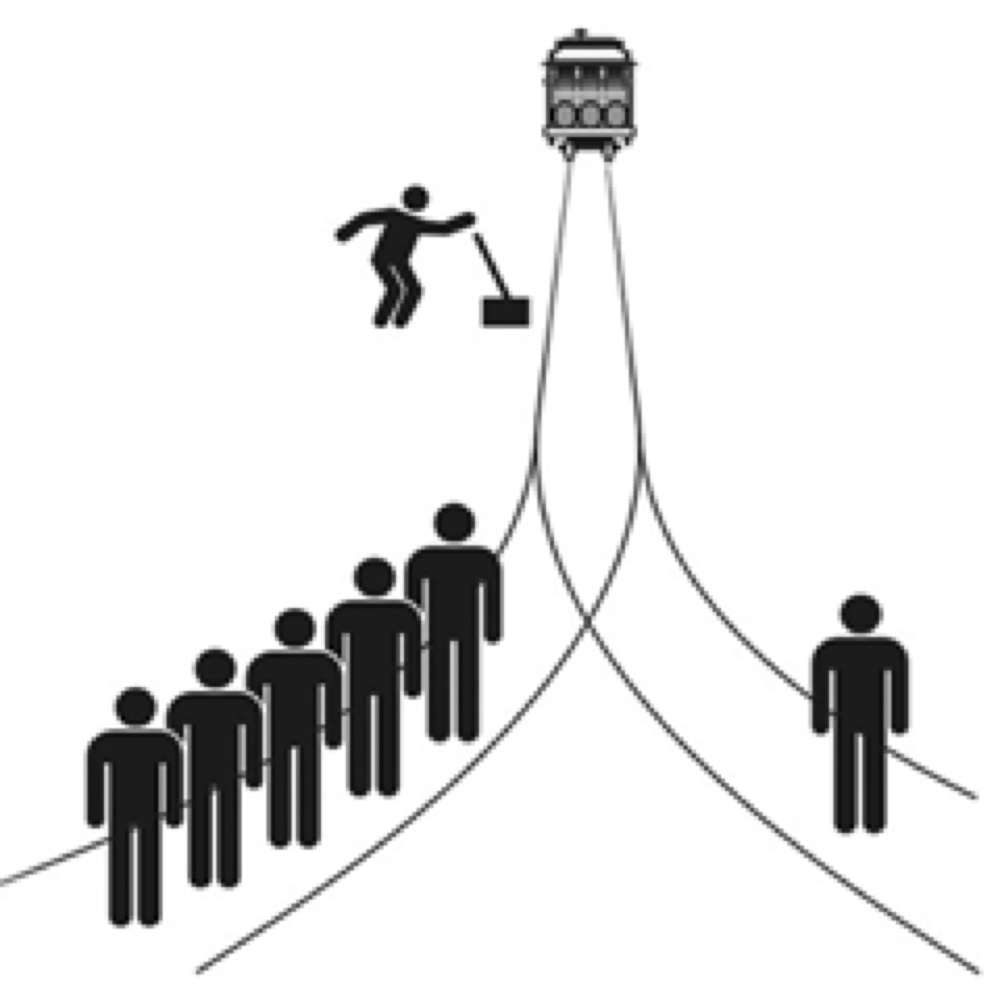

L’éthique appliquée, traditionnellement appelée casuistique, consiste à résoudre les problèmes pratiques par une discussion entre des principes généraux (règles), des cas similaires (jurisprudence) et la considération des particularités du cas étudié (cas réel). On analyse alors rationnellement des cas d’école de dilemmes moraux, tels que le « dilemme du tramway » *.

* Le dilemme du tramway : C’est une expérience de pensée où une personne actionnant l’aiguillage d’un tramway hors de contrôle doit choisir entre deux voies possibles : cinq hommes travaillent sur l’une tandis qu’un homme seul est sur l’autre. Quel que soit le choix, le tramway causera donc la mort d’une ou plusieurs personnes. Sous une forme générale il s’agit de la justification d’un geste qui bénéficie à un groupe de personnes, mais nuit à une autre personne. Dans de telles circonstances, est-il moral d’effectuer ce geste ?

Parfois on invoquera la doctrine du double, voire du triple, effet que l’on attribue à saint Thomas d’Aquin, par laquelle il est permis dans certaines circonstances de commettre une action ayant à la fois de bonnes et de mauvaises conséquences.

Ces cas d’école aux déclinaisons diverses comme sur le site Internet du Massachusetts Institute of Technology (MIT), Moral Machine - Human Perspectives on Machine Ethics (http://moralmachine.mit.edu/), sont des modèles qui posent toujours des alternatives entre deux actions ayant des conséquences létales. Ils sont en général assez discriminants entre certains raisonnements de type utilitariste ou du double effet et peuvent éventuellement faire l’objet d’une programmation logique rationnelle pour des robots (4).

Mais le très large échantillon de réponses aux dilemmes posés par des VA sur Moral Machine, soit 40 millions de réponses dans 10 langues de la part de millions de personnes de 233 pays ou territoires (5), a montré des préférences éthiques globales essentiellement utilitaristes, c’est-à-dire minimisant le nombre de morts mais renonçant au suicide, ainsi que des variations éthiques liées à des traits culturels et institutionnels. Une telle photographie sociologique des réponses moyennes n’est donc pas nécessairement conforme à une programmation logique rationnelle, ce qui pose la question du fondement d’une éthique appliquée dans un contexte démocratique.

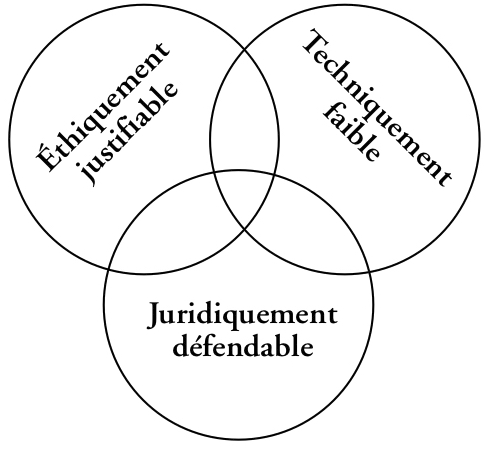

Les situations réelles sont cependant plus complexes et comportent des zones « grises » et du flou par rapport aux situations modèles que sont les dilemmes. Il y est davantage question de risques pris et éventuellement partagés pendant un temps court où il faut réagir à chaud. Dès lors, il convient de se pencher sur le problème du traitement par les algorithmes d’IA du robot d’un compromis équilibré entre ce qui est éthiquement justifiable, techniquement possible et légalement défendable (« défendable » et non « permis » : enfreindre le Code de la route n’est pas permis mais il est juridiquement défendable de le faire pour sauver une vie). Le diagramme de la Figure 2, illustre cette recherche d’un compromis équilibré.

Figure 2 : La recherche d’un compromis entre les dimensions éthique, juridique et technique d’une décision à prendre dans un cas concret d’usage d’un robot et particulièrement d’un VA (d’après Ryan Jenkins (6)).

Réflexions en cours sur l’éthique du véhicule autonome

Sur l’éthique du VA en particulier, les publications scientifiques et techniques dépassent largement la dizaine (7) et plusieurs pays ont déjà émis des recommandations dans des documents officiels.

Aux États-Unis, le ministère des Transports (DoT) et l’autorité fédérale sur la sécurité du trafic autoroutier (NHTSA) ont publié en 2016 un document (8) dont un paragraphe (§11 Ethical Considerations, p. 26) est consacré aux aspects éthiques. Il y est stipulé en particulier que « les algorithmes de résolution de situations conflictuelles [entre des objectifs de sécurité, de mobilité et de légalité] devront être développés de manière transparente à partir des demandes des autorités réglementaires fédérale et étatique, des conducteurs et des passagers et des usagers vulnérables de la route, en prenant en compte les conséquences des actions d’un véhicule hautement automatisé ».

Au niveau de l’Union européenne, le Parlement européen consacre plusieurs articles aux VA dans sa résolution du 16 février 2017 (9). En particulier, il « attire l’attention sur le fait que le délai de réaction du conducteur en cas de reprise de contrôle imprévue du véhicule revêt une importance capitale et demande, par conséquent, aux acteurs concernés de prévoir des valeurs réalistes qui seront déterminantes pour les questions relatives à la sécurité et à la responsabilité » et il « estime nécessaire d’envisager de modifier certains accords internationaux tels que la Convention de Vienne du 8 novembre 1968 sur la circulation routière et la Convention de La Haye du 4 mai 1971 sur la loi applicable en matière d’accidents de la circulation routière ». De plus un avis du Comité économique et social européen (CESE), organe consultatif de l’UE représentant les organisations de la société civile des États-membres, adopté en séance plénière le 5 juillet 2017 (10), souligne que « l’introduction et le déploiement de transports sans pilote et autonomes soulèvent également la question des règles de circulation, et notamment celles ayant trait aux aspects éthiques », et qu’« il convient d’harmoniser les règles de circulation au sein du marché intérieur avec pour visée une harmonisation accrue au niveau international ».

En Allemagne, une Commission fédérale sur l’éthique de la conduite automatisée et connectée a été mise en place le 30 septembre 2016 par le ministère fédéral des Transports et des Infrastructures digitales (BMVI). Il s’agit d’une commission interdisciplinaire d’experts ayant pour mission d’« élaborer les principes directeurs éthiques nécessaires à la conduite automatisée et connectée ». Elle a publié un premier rapport édictant des « règles éthiques » assorti d’une bibliographie assez exhaustive des travaux académiques sur l’éthique du véhicule autonome (11). Cinq des vingt règles portent spécifiquement sur les situations de dilemmes en cas d’accident inévitable de véhicules entièrement automatisés.

En France, le plan Nouvelle France Industrielle (NFI) sur la mobilité écologique et le véhicule autonome, ainsi que la Plateforme de la filière automobile et mobilité (PFA) travaillent déjà avec le ministère des Transports sur l’évolution du contexte juridique de la conduite automatisée en termes de responsabilité civile ou pénale. Quelques études portant sur les aspects éthiques des VA face à des dilemmes sont menées dans le cadre de recherches académiques :

i) projet de l’Agence nationale de la recherche (ANR) Ethicaa (12),

ii) travaux de Jean-François Bonnefon de la Toulouse School of Economics avec le MIT (13),

iii) travaux du Laboratoire ETHICS (Ethics on experiment, Transhumanism, Human Interactions, Care & Society) de l’Université catholique de Lille (14),

iv) projet ANR AVEthics sous la direction d’Ebru Dogan de l’Institut Vedecom (Institut du véhicule décarbonné et communicant et de sa mobilité) (15).

Parallèlement, la Commission de réflexion sur l’éthique de la recherche en sciences et technologies du numérique de l’alliance Allistene (Cerna), qui rassemble tous les organismes de publics de recherche spécialisés (INRIA, CNRS, CEA, Institut Mines-Telecom, Universités, Grandes écoles), a publié deux rapports sur l’éthique de la recherche en robotique (16) et sur l’éthique de la recherche en apprentissage-machine (17) en mentionnant le cas des VA.

Enfin, au plan international, l’Institute for Electrical and Electronics Engineers (IEEE) a lancé en 2015 une « Global Initiative for Ethical Considerations in Artificial Intelligence and Autonomous Systems ». Un document de travail évolutif a été mis en ligne et plusieurs propositions de standards sont en chantier avec des groupes de travail ouverts dont trois propositions (P7000, P7001 et P7007) sont pertinentes pour les véhicules autonomes (18).

Éthique et statut juridique des robots autonomes

Bien que l’éthique vise une justification des actes et de leurs intentions alors que le droit vise une permission ou une sanction des actes eux-mêmes, il faut articuler l’une et l’autre. À ce propos, certains juristes veulent conférer une personnalité juridique aux robots ce qui suscite une intense polémique.

Ainsi, le rapport du Parlement européen du 16 février 2017 sur la mise en place de règles de droit civil relatives à la robotique et l’IA propose « la création d’une personnalité juridique spécifique aux robots », laquelle impliquerait que les robots pourraient être tenus pour civilement responsables des dommages qu’ils causeraient. Cela permettrait de considérer les robots autonomes les plus sophistiqués « comme des personnes électroniques dotées de droits et de devoirs bien précis, y compris celui de réparer tout dommage causé à un tiers ». Le rapport considère comme une personne électronique « tout robot qui prend des décisions autonomes de manière intelligente ou qui interagit de manière indépendante avec des tiers ». Il s’agirait ensuite de mettre en place un « régime d’assurance obligatoire en vertu duquel, les fabricants ou les propriétaires de robots seraient tenus de contracter une police d’assurance couvrant les dommages potentiels causés par les robots ».

Mais dans son avis sur l’IA du 31 mai 2017 (19) le CESE s’oppose formellement à la mise en place d’une forme de personnalité juridique pour les robots ou l’IA pour deux principales raisons. Le CESE pointe d’abord, le « risque moral inacceptable » inhérent à une telle démarche. « Si cette proposition se concrétise, les effets correctifs préventifs découlant du droit de la responsabilité civile disparaîtront dès lors que le fabricant n’assumera plus le risque de responsabilité, celui-ci ayant été transféré au robot (ou au système d’IA) ». Autrement dit, sachant qu’ils ne seraient pas tenus pour responsables en cas d’incidents, les fabricants pourraient prendre plus de risques. Le CESE craint, en outre, « le risque d’utilisation impropre et d’abus d’une telle forme juridique » si les incidents dus à une mauvaise utilisation peuvent être systématiquement imputés à l’IA ou au robot intelligent par son propriétaire.

Pistes pour l’élaboration d’une politique éthique du véhicule autonome

On analyse ici les caractéristiques propres des véhicules autonomes, en fonction de leurs usages dans leur environnement et leur écosystème, dans le but de construire une politique éthique du véhicule autonome qui soit à la fois pertinente, pragmatique, cohérente et articulée avec son volet juridique et réglementaire, dans un contexte français, européen et international.

Les véhicules autonomes sont des robots particuliers

Tout d’abord, contrairement aux robots spécialisés dans d’autres secteurs d’application (aéronautique, défense, chirurgie, production industrielle, surveillance), les véhicules autonomes ne sont pas utilisés par des experts mais par des non-spécialistes.

De plus, ils sont immergés dans un environnement ouvert (routes, villes) et de plus en plus complexe, en interaction avec de nombreux autres agents, qu’il s’agisse des autres véhicules (voitures, bus, véhicules utilitaires ou industriels, automatisés ou non) et de leurs occupants, de personnes aux moyens de locomotion plus « doux » mais aussi plus vulnérables (piétons, cyclistes), d’animaux, de végétation, d’obstacles naturels, d’objets divers et d’infrastructures sur ou le long des voies de circulation.

Par ailleurs, toutes les parties prenantes de l’écosystème de la mobilité sont concernées par l’usage des véhicules autonomes : conducteurs et usagers des véhicules, autres utilisateurs de la route, constructeurs automobiles, compagnies d’assurances, exploitants de flottes de transport public, gestionnaires d’infrastructures, autorités locales et autorités réglementaires, etc.

Enfin, les êtres humains sont présents à la fois à l’extérieur et à l’intérieur du véhicule autonome robotisé, de sorte qu’est remise en question la 3e « loi de la robotique » d’Asimov * dans la mesure où celle-ci induit que le robot doit se sacrifier en dernière instance en cas de risque létal pour un être humain. En effet, le robot-véhicule a lui-même « charge d’âme » puisqu’il emporte en son sein des personnes qui lui confient leur sécurité.

* Les trois lois de la robotique (20) Formulées par l’écrivain de science-fiction Isaac Asimov, ce sont des règles auxquelles tous les robots qui apparaissent dans ses romans doivent obéir : 1. Un robot ne peut porter atteinte à un être humain, ni, en restant passif, permettre qu’un être humain soit exposé au danger. 2. Un robot doit obéir aux ordres qui lui sont donnés par un être humain, sauf si de tels ordres entrent en conflit avec la première loi. 3. Un robot doit protéger son existence tant que cette protection n’entre pas en conflit avec la première ou la deuxième loi.

Perception, décision, action et IA des véhicules autonomes

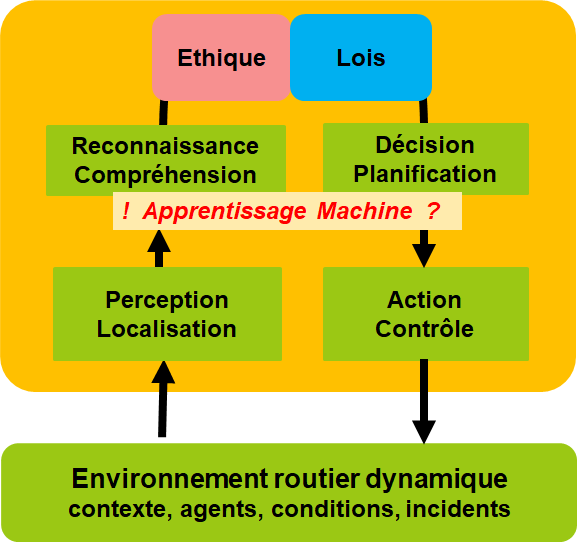

Un véhicule autonome peut être caractérisé par quatre champs fonctionnels dans un environnement routier dynamique et un contexte comportant d’autres agents parfois imprévisibles dans des conditions engendrant des incidents :

– perception et localisation dans l’environnement routier dynamique par de multiples capteurs ;

– compréhension de la scène, reconnaissance et valorisation des objets et agents observés par des algorithmes d’apprentissage ;

– décision et planification de trajectoire et de vitesse instruites par des règles codées ou apprises ;

– action et contrôle dans l’environnement routier dynamique par des actionneurs et des algorithmes de pilotage.

Ces champs fonctionnels dépendent évidemment l’un de l’autre. Si la perception est mauvaise et entraîne un défaut de reconnaissance et d’identification d’agents sur la route, la décision prise par le véhicule pourra être jugée contraire aux principes éthiques à cause de ce défaut de perception. À l’autre bout de la chaîne fonctionnelle, une défaillance des actionneurs et du contrôle dans l’environnement dynamique rencontré pourra entraîner une action non conforme à la décision, fut-elle prise selon un principe éthique.

Figure 3 : Diagramme fonctionnel pour un véhicule autonome et positionnement de la question sur le rôle de l’apprentissage-machine dans les algorithmes d’IA.

En ce qui concerne le type d’algorithmes développés et mis en œuvre au sein de l’IA du véhicule dans les champs de la perception et de la décision, il convient, sans rentrer dans le détail, de distinguer au premier abord les méthodes déterministes, dont la chaîne causale peut être retracée, des méthodes d’apprentissage-machine dont la performance évolue et s’améliore en fonction des données d’apprentissage. Ces dernières ont récemment fait des progrès spectaculaires dus tant à la croissance des puissances de calcul et à la capacité de traiter des données massives d’apprentissage, qu’aux méthodes algorithmiques mises en œuvre utilisant des réseaux de neurones multicouches. Parmi les méthodes d’apprentissage-machine, on distingue :

• L’apprentissage supervisé où les données utilisées sont « annotées » préalablement par des « experts ».

• L’apprentissage non-supervisé où aucun expert n’est requis pour annoter les données de sorte que l’algorithme découvre par lui-même la structure des données.

• Et l’apprentissage par renforcement dont le but est d’apprendre, à partir d’expériences, ce qu’il convient de faire dans différentes situations.

Quant à l’apprentissage profond, il désigne la mise en œuvre de réseaux de neurones multicouches, récurrents ou convolutifs, qui augmentent considérablement la performance de l’apprentissage (21).

Dans le champ de la perception des véhicules autonomes, les méthodes d’apprentissage-machine supervisé et profond sont devenues incontournables. Ce sont elles qui ont fait le succès de sociétés comme MobilEye dans le domaine de la perception par caméra.

Dans le champ de la décision, en revanche, l’alternative entre méthodes déterministes et méthodes par apprentissage est encore ouverte car il en va de la traçabilité et de l’explicabilité de la décision prise, et donc de la recherche de la responsabilité en cas d’accident. De ce point de vue, les méthodes déterministes doivent être privilégiées a priori. Néanmoins, on pourrait imaginer que le véhicule apprenne à réagir « éthiquement » au mieux en exploitant des algorithmes d’apprentissage supervisé ou par renforcement entraînés sur une base de données de décisions prises dans des situations simulées de dilemmes. Mais cela supposerait que ces données soient « annotées » du point de vue éthique par des experts, et cela renvoie in fine aux principes éthiques adoptés et à la sélection des experts.

Des réponses éthiques en fonction du contexte d’usage et du temps de réaction

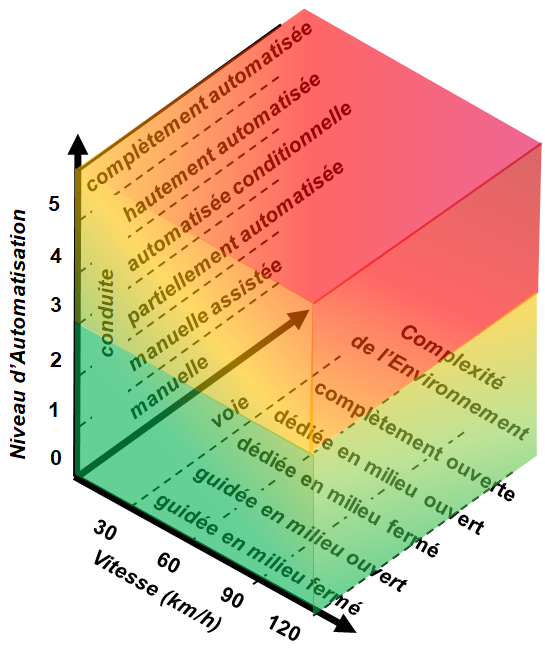

La première réponse éthique à apporter aux risques que comporte la conduite autonome est de garantir que la sécurité des occupants du véhicule et des passagers dans les conditions d’usage autorisées sera améliorée par rapport à une conduite manuelle. C’est la raison pour laquelle l’introduction des véhicules autonomes se fera progressivement en fonction :

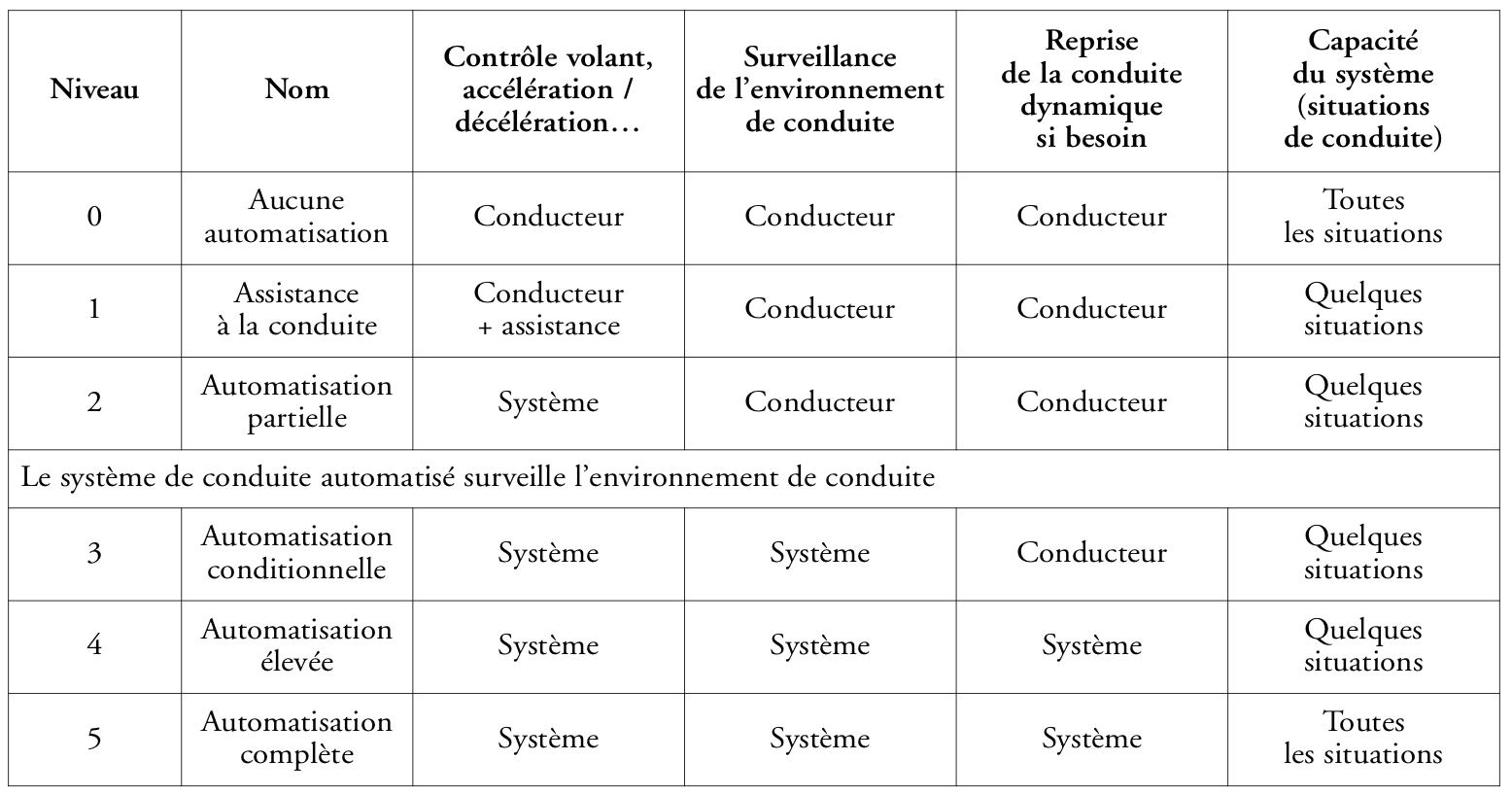

– du niveau d’automatisation du véhicule (22) (Figure 4),

– de la vitesse maximale du véhicule,

– de la complexité de l’environnement et du degré d’ouverture des voies de circulation.

En effet, c’est la combinaison de ces paramètres et éléments de contexte qui déterminera le niveau de risque accidentel associé à l’usage des véhicules autonomes. De plus, la prise de décision du véhicule autonome et sa réponse en termes de planification de trajectoire et de contrôle dépendront du temps restant avant la collision, c’est-à-dire du temps alloué à la réaction.

Figure 4 : Définition des niveaux d’automatisation des VA selon le standard international SAE J3016

La Figure 5 illustre la criticité de la prise de décision en fonction des trois paramètres que nous avons inventoriés.

À très faible vitesse (< 30 km/h), devant une scène potentiellement accidentogène mais sans risque létal, et avec un temps avant la collision de plusieurs secondes, la réaction la plus sûre sera sans doute de respecter le Code de la route, ralentir et freiner, par une prise de décision selon une méthode déterministe. Dans ce cas, il n’y a pas à proprement parler de dilemme éthique : il s’agit simplement de bien conduire comme le ferait un conducteur agissant rationnellement. Autrement dit, la sécurité l’emporte sur les considérations éthiques.

En revanche, dans une situation d’urgence à vitesse élevée, où le temps de réaction est trop court et la situation trop complexe pour se réduire à un simple cas d’école susceptible d’être traité selon une programmation logique rationnelle, un algorithme de prise de décision rapide combinant perception, valorisation éthique des agents et des obstacles (selon une échelle et une métrique définies a priori), et analyse des risques sera nécessaire pour réagir et adapter en temps réel la trajectoire et vitesse du véhicule. La question proprement éthique concernant l’algorithme portera alors sur la valorisation éthique des agents et des obstacles, et sur l’acceptabilité du risque pour les occupants du véhicule comme pour les agents extérieurs.

À propos de la notion de valorisation ou de métrique éthique, il convient ici de mentionner que parmi les vingt règles proposées par la Commission allemande sur l’éthique de la conduite automatisée et connectée (23), la règle n° 9 stipule que « lors d’un risque d’accident, il est interdit de trancher selon des caractéristiques personnelles ». Autrement dit, la programmation de la décision du VA ne devrait pas distinguer entre un enfant, une personne âgée, un homme ou une femme même si ses capacités de perception et d’apprentissage lui permettent de les reconnaître. C’est un point qui peut mériter discussion.

Figure 5 : Illustration de la criticité des algorithmes de décision éthique pour un VA en fonction du niveau d’automatisation (≥ 3), de la vitesse et de la complexité de l’environnement

Des outils de simulation numérique

La complexité des cas d’usage et des dilemmes possibles, et l’impossibilité de tester les réponses des véhicules dans des situations réelles, compte tenu de leur dangerosité, suppose de recourir à des mises en scène et à des tests des algorithmes par simulation numérique dans ce que l’on appelle des « jeux sérieux » (serious games), notion qui englobe tous les jeux vidéo qui s’écartent du seul divertissement.

Or, on peut constater des progrès majeurs dans la qualité de la simulation d’environnements dynamiques dans les jeux vidéo et les simulateurs de conduite. On commence aussi à produire des modules spécifiques de modélisation et de simulation de fonctions d’un véhicule automatisé. Il peut s’agir de la perception par un capteur (radars, lidars, etc.) ou du contrôle de véhicule : suivi de marquage ou de voie, régulation de vitesse, évitement d’obstacle, ou changement de voie. Cependant, on ne dispose pas encore d’un environnement complet de modélisation à même de simuler le comportement d’un véhicule totalement autonome, c’est-à-dire entièrement robotisé, dans un environnement dynamique complexe en interaction avec divers agents, de manière la plus réaliste possible.

Pour ce qui concerne le véhicule autonome, il s’agit, comme indiqué au §2.2, de développer des algorithmes constituant un sous-module d’éthique artificielle dans le champ fonctionnel de la décision, et de l’intégrer dans un environnement logiciel couvrant les divers champs de modélisation :

– environnement routier dynamique avec ses agents générant des incidents,

– perception et localisation,

– reconnaissance et compréhension,

– décision, instruite par les aspects éthique et juridique, et planification,

– action et contrôle.

Une fois mis au point, un tel outil pourra servir de test des réactions du véhicule en fonction du type d’algorithme de prise décision éthique, des paramètres de la valorisation éthique des agents et des obstacles, et des seuils de risques acceptables. Il pourra aussi servir d’outil d’aide à la décision pour des non-spécialistes amenés à juger du bien-fondé et de l’acceptabilité de ces algorithmes en visualisant les scènes et les conséquences de tel ou tel choix technique. Il pourra aussi être utilisé comme moyen de formation des ingénieurs et concepteurs d’algorithmes au sein des entreprises.

Éthique artificielle des VA et niveaux de responsabilité

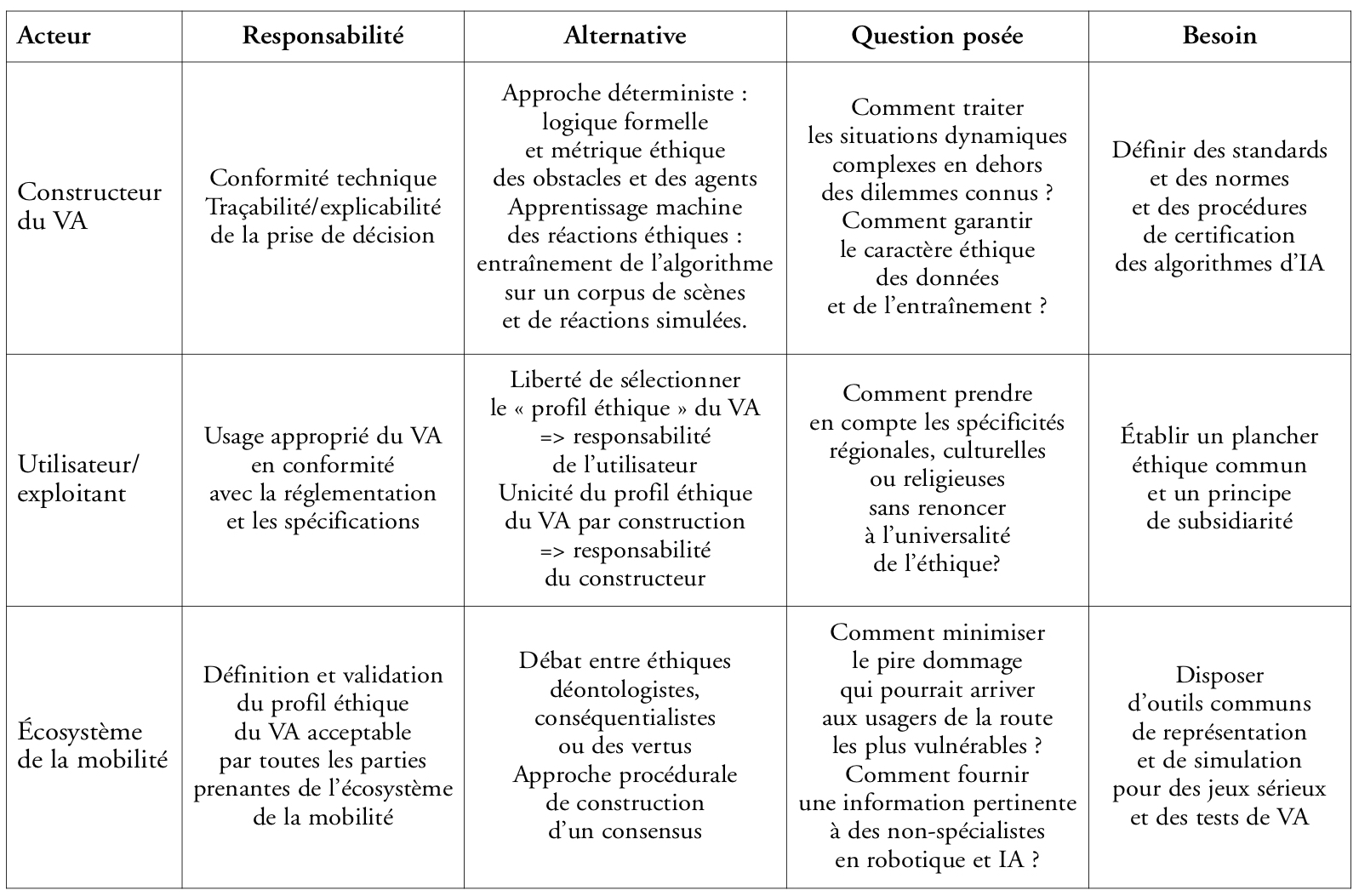

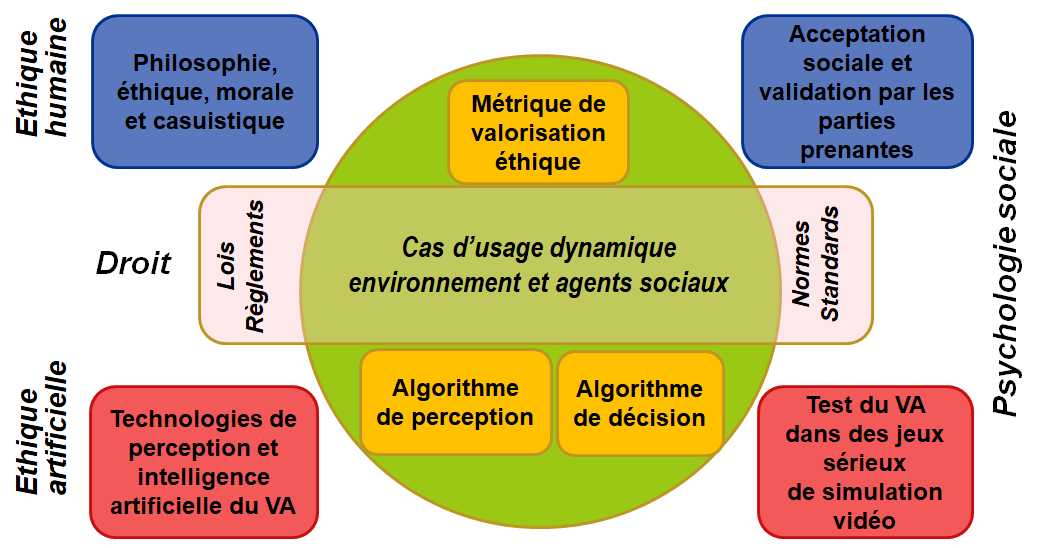

Construire une politique éthique du VA acceptable et justifiable socialement, défendable juridiquement et techniquement pertinente (cf. §1.3) suppose de travailler à différents niveaux : philosophie, intelligence artificielle, droit, psychologie sociale et chaque niveau doit mobiliser les acteurs responsables pertinents.

• Les constructeurs et équipementiers automobiles sont responsables de la qualité de la perception, de la prise de décision et du contrôle du VA. Ils ont la charge de mettre au point et valider les algorithmes d’éthique artificielle dans l’IA des véhicules et de fournir, le cas échéant, une traçabilité de la décision prise par le véhicule (d’où la question importante de l’alternative entre méthodes déterministes et méthodes d’apprentissage, cf. §2.2). Mais ceci suppose que ces algorithmes soient construits selon des normes et des standards à définir et certifiés par des organismes indépendants.

• Les utilisateurs ou les exploitants des véhicules sont responsables du respect des conditions dans lesquelles les véhicules peuvent être opérés en mode automatique. Si ces conditions sont respectées, les utilisateurs ne sont pas responsables de la prise de décision du véhicule autonome face à un dilemme éthique. Néanmoins la question a été posée de savoir si le profil éthique de l’IA du véhicule ne pourrait pas être ajusté parmi différentes options plus ou moins égoïstes ou altruistes (24). Dans ce cas, la responsabilité de l’utilisateur ou de l’exploitant du VA serait évidemment engagée en cas d’accident. Mais on peut aussi estimer que le simple fait de prendre le risque d’utiliser ou opérer un véhicule en mode automatique implique une responsabilité par rapport à la probabilité résiduelle d’accident (25). Quoi qu’il en soit, il convient sans doute comme le propose Ryan Jenkins (26) d’établir un plancher éthique commun et de l’assortir d’un principe de subsidiarité (27) quant à son application régionale.

• Les parties prenantes de l’écosystème de la mobilité : constructeurs et équipementiers automobiles, usagers et exploitants des VA, autres usagers de la route, gestionnaires d’infrastructures, compagnies d’assurances, collectivités territoriales, autorités réglementaires, etc., sont responsables de la validation a priori et a posteriori des réponses éthiques à apporter à des dilemmes. Certaines des orientations prises pourront dépendre du contexte culturel et régional selon le principe de subsidiarité. Il s’agira alors d’articuler spécifications techniques internationales et adaptations locales.

Figure 6 : Niveaux de responsabilité, alternatives techniques et éthiques et questions posées pour construire une politique éthique du VA.

Le tableau de la Figure 6 reprend les responsabilités des acteurs à chaque niveau, les alternatives et les questions posées quant à la prise de décision du VA.

Mobiliser ces acteurs et mettre en place un processus adapté de discussion, de validation et de certification des algorithmes suppose de constituer des comités techniques et éthiques ad hoc, en garantissant leur expertise et leur représentativité, et en mettant à leur disposition des outils partagés d’aide à la décision.

Recommandations et propositions

Fédérer l’écosystème de la mobilité en France sur l’éthique du VA

Le plan NFI sur le Véhicule autonome et la PFA ont déjà validé la proposition de créer un groupe de travail pour l’élaboration d’une « politique éthique du véhicule autonome ». C’est un bon point de départ mais il faudrait y associer des instances représentatives des autres usagers de la route, des gestionnaires d’infrastructures, des compagnies d’assurances, des collectivités territoriales et des autorités réglementaires pour impliquer tout l’écosystème de la mobilité. Le plan NFI et l’institut Vedecom sont certainement des cadres propices à cette ouverture.

Il faudrait aussi évaluer la pertinence de solliciter les avis d’une commission ou d’un comité national d’éthique comprenant des personnalités qualifiées de la société civile, à l’instar de la Commission fédérale sur l’éthique de la conduite automatisée et connectée constituée en Allemagne (28). Ce comité pourrait d’ailleurs constituer un groupe de travail sectoriel, aux côtés d’autres comités sectoriels pour la médecine, la défense ou encore d’autres champs d’application, au sein d’un futur comité national d’éthique qui couvrirait le champ du numérique, de la robotique et de l’IA conformément aux recommandations du rapport de Cédric Villani (29).

Partager des travaux de recherche

Plusieurs sujets de recherche académique et des travaux de développement scientifique et technique concernant l’éthique du véhicule autonome pourraient et devraient être partagés entre tous les acteurs de l’écosystème de la mobilité. Il s’agit en particulier des recherches en sciences humaines et sociales (philosophie, psychologie, sociologie…), de recherches en IA sur les méthodes déterministes ou d’apprentissage, et, de manière très concrète, du développement d’un outil de simulation numérique pour tester par jeu sérieux les réactions de véhicules autonomes face à des dilemmes. Ceci afin de constituer un corpus de travaux pour alimenter le groupe de travail qui pourrait élaborer des propositions de normes et de standards.

Articuler éthique, droit et réglementation du VA

Bien que l’éthique ne se réduise pas à la question juridique de la responsabilité, il est indispensable de faire dialoguer entre eux le groupe de travail sur la politique éthique du VA, en cours de constitution, et les groupes de travail déjà en fonction depuis quelques années sur les questions juridiques, en particulier au sein du CSTA (Comité de standardisation technique automobile) de la PFA. Il s’agit d’élaborer des directives et un cadre réglementaire pour la robotique et l’IA appliquées à l’automobile.

Promouvoir une éthique de la robotique et de l’IA dans l’entreprise

Dans quasiment toutes les grandes entreprises et les organismes publics de recherche, des codes ou des chartes de déontologie ou d’éthique sont maintenant soumis aux employés qui doivent s’engager à les respecter. Il faudrait compléter cette démarche par des formations à l’éthique de la robotique et de l’IA, par des règles internes de comportement et par des possibilités de recours pour les chercheurs, les ingénieurs et opérateurs en prise avec des problématiques éthiques de développement ou d’utilisation de robots et d’algorithmes d’IA, et plus particulièrement de VA. L’IEEE recommande d’ailleurs que cette fonction soit assumée au plus haut niveau : « Companies need to create roles for senior level marketers, ethicists or lawyers who can pragmatically implement ethically aligned design » (30) (p. 41).

Être force de proposition en Europe et au niveau international

Les travaux menés au niveau français devraient être relayés par des discussions et des propositions à l’échelle européenne et internationale. Plusieurs canaux peuvent être utilisés parallèlement :

• Échanges bilatéraux entre le plan NFI sur le VA et ses homologues nationaux (Allemagne, Royaume-Uni, Italie, Pays-Bas, Espagne, Suède…).

• Projets collaboratifs européens et plateformes ERTRAC (www.ertrac.org) et ERTICO (www.ertico.com).

• Trilateral Automation in Road Transportation Working Group (EU-USA-Japan ITS Cooperation) (31).

• Groupes de travail de l’IEEE sur les propositions de standards (32).

* * *

Le schéma de la Figure 7 essaie de synthétiser les différents enjeux éthiques, juridiques et techniques de la problématique de construction d’une politique éthique du VA en soulignant la dimension collective de sa construction et de son acceptation. L’expérience récente des comités consultatifs d’éthique sur les questions de bioéthique montre que c’est une tâche complexe mais néanmoins indispensable.

Figure 7 : Schéma récapitulatif de la problématique d’une politique éthique du véhicule autonome.

(1) Cette affirmation doit cependant être contrebalancée par une affirmation inverse, quoique plus difficilement vérifiable, que des réactions humaines dans des cas critiques permettent d’éviter nombre d’accidents mieux que ne saurait le faire une réaction programmée.

(2) Brown Mike, « Mercedes’s Self-Driving Cars Will Kill Pedestrians Over Drivers », Inverse, 14 octobre 2016 (www.inverse.com/).

(3) Powers Thomas M., « Prospect for a Kantian Machine », IEEE Intelligent Systems, vol. 21, n° 4, juillet-août 2006, p. 46-51.

Ganascia Jean-Gabriel, « Modeling Ethical Rules of Lying with Answer Set Programming », Ethics and Information Technology, vol. 9, n° 1, mars 2007, p. 39-47.

Wallach Wendell et Allen Colin, Moral Machines: Teaching Robots Right from Wrong, Oxford University Press, 2010, 288 pages.

Bostrom Nick et Yudkowsky Eliezer, « The Ethics of Artificial Intelligence », in Frankish Keith et Ramsey William (dir.), Cambridge Handbook of Artificial Intelligence (2e édition), Cambridge University Press, 2014, p. 316-334.

Lin Patrick, Abney Keith et Bekey George A. (dir.), Robot Ethics: The Ethical and Social Implications of Robotics, MIT University Press, 2012, 400 pages.

Trappl Robert (dir.), A Construction Manual for Robots’ Ethical System. Requirements, Methods, Implementations, Springer, 2015, 210 pages.

Tessier Catherine, « Conception et usage des robots : quelques questions éthiques », Techniques de l’Ingénieur, 10 novembre 2016.

(4) Tessier C., « Conception et usage des robots : quelques questions éthiques », ibid.

Bonnemains Vincent, Saurel Claire et Tessier Catherine, « Embedded Ethics - Some Technical and Ethical Challenges », Journal of Ethics and Information Technology, vol. 20, n° 1, mars 2018, p. 41-58.

(5) Awad Edmond, Dsouza Sohan, Kim Richard, Schulz Jonathan, Henrich Joseph, Shariff Azim, Bonnefon Jean-François et Rahwan Iyad, « The Moral machine experiment », Nature, 24 octobre 2018.

(6) Jenkins Ryan, « Autonomous Vehicles Ethics and Law: Toward and Overlapping Consensus », report New America Digital Industries Initiative, septembre 2016 (www.newamerica.org/), 27 pages.

(7) Jenkins R., ibid.

Goodall Noah Joseph, « Machine ethics and automated vehicles » in Meyer Gereon et Beiker Sven (dir.), Road Vehicle Automation, Springer, 2014, p. 93-102 ; Goodall N.J., « Ethical Decision Making During Automated Vehicle Crashes », Transportation Research Record: Journal of the Transportation Research Board, n° 2424, décembre 2014, Transportation Research Board of the National Academies, p. 58-65.

Sandberg Anders et Bradshaw-Martin Heather, « La Voiture Autonome et ses implications morales » (traduit de l’anglais par Mona Gérardin-Laverge), Multitudes, vol. 2015/1, n° 58, p. 62-68 (www.cairn.info/).

Hevelke Alexander et Nida-Rümelin Julian, « Responsibility for Crashes of Autonomous Vehicles: an Ethical Analysis », Science and Engineering Ethics, vol. 21, n° 3, juin 2015, p. 619-630 (https://link.springer.com/).

Lin Patrick, « Why Ethics Matters for Autonomous Cars » & Gerdes J. Christian et Thornton Sarah M., « Implementable Ethics for Autonomous Vehicles » in Maurer Markus, Gerdes J.C., Lenz Barbara et Winner Hermann (dir.), Autonomes Fahren - Technische, rechtliche und gesellschaftliche Aspekte, Springer, 2015, p. 69-85 et p. 87-102 (https://link.springer.com/).

Bonnefon Jean-François, Shariff Azim et Rahwan Iyan, « The Social Dilemma of Autonomous Vehicles », Science, vol. 352, n° 6293, 24 juin 2016, p. 1573-1576.

Thornton Sarah M., Pan Selina, Erlien Stephen M. et Gerdes J. Christian, « Incorporating Ethical Considerations into Automated Vehicle Control », IEEE Transactions on Intelligent Transportation Systems, vol. 18, n° 6, 2017, p. 1429-1439 (https://ieeexplore.ieee.org/document/7588150).

(8) US Department of Transport (DoT) et National Highway Traffic Safety Administration (NHTSA), Federal Automated Vehicles Policy—Accelerating the Next Revolution in Roadway Safety, septembre 2016, 116 pages (www.transportation.gov/).

(9) Parlement européen, Résolution contenant des recommandations à la Commission Européenne (2015/2103(INL)), 16 février 2017 (www.europarl.europa.eu/).

(10) Kyla-Harakka-Rijolana Tellervo (rapporteur), Les conséquences de la numérisation et de la robotisation des transports sur l’élaboration des politiques de l’UE, CESE, avis d’initiative adopté le 5 juillet 2017 (www.eesc.europa.eu/).

(11) Bundesministerium für Verkher und digitale Infrastruktur (BMVI), « III. Ethische Regeln für den automatisierten und vernetzten Fahrzeugverkehr » [Règles éthiques pour la circulation des véhicules automatisés et connectés], Automatisiertes und Vernetztes Fahren, juin 2017 (www.bmvi.de/).

(12) Bonnemains V., Saurel C. et Tessier C., « Embedded Ethics - Some Technical and Ethical Challenges », op. cit.

(13) Awad E., Dsouza S., Kim R., Schulz J., Henrich J., Shariff A., Bonnefon J.-F. et Rahwan I., « The Moral machine experiment », op. cit.

Bonnefon J.-F., Shariff A. et Rahwan I., « The Social Dilemma of Autonomous Vehicles », op. cit.

(14) Doat David, Romaniuc Rustam et Vaillant Nicolas, « Quelle éthique pour la voiture autonome ? », La Tribune, 12 mars 2017 (www.latribune.fr/) ; 2100 : Big Data, intelligence artificielle, transhumanisme. Prospective et éthique aux frontières de l’inconnu (actes de colloque), Université catholique de Lille, 13-14 mars 2017, p. 45.

(15) Dogan Ebru, Chatila Raja, Chauvier Stéphane, Evans Katherine, Hadjixenophontos Petria et Perrin Jérôme, « Ethics in the Design of Automated Vehicles: the AVEthics Project », Proceedings of the workshop on Ethical Design of Intelligent Agents (EDIA) in the European Conference on Artificial Intelligence, 31 août 2016.

(16) Cerna, Éthique de la recherche en robotique, novembre 2014, 63 pages (http://cerna-ethics-allistene.org/).

(17) Cerna, Éthique de la recherche en apprentissage-machine (édition provisoire), juin 2017, 33 pages (http://cerna-ethics-allistene.org/).

(18) Institute for Electrical and Electronics Engineers (IEEE), Ethically Aligned Design (v1, December 2016) ; P7000 - Model Process for Addressing Ethical Concerns During System Design ; P7001 - Transparency of Autonomous Systems ; P7007 - Ontological Standard for Ethically Driven Robotics and Automation Systems

(https://standards.ieee.org/).

(19) Muller Catelijne (rapporteur) : L’intelligence artificielle – Les retombées de l’intelligence artificielle pour le marché unique (numérique), la production, la consommation, l’emploi et la société, adopté le 31 mai 2017, CESE (www.eesc.europa.eu/).

(20) Heudin Jean-Claude, Les 3 lois de la robotique. Faut-il avoir peur des robots ?, Science-eBook, 2014, 130 pages.

(21) Cerna, Éthique de la recherche en apprentissage-machine, op. cit.

(22) Selon la classification officielle proposée par la Society of Automative Engineers (SAE) dans le standard international SAE J3016 : Taxonomy and Definitions for Terms Related to Driving Automation Systems for On-Road Motor Vehicles (http://standards.sae.org/) qui a été adopté par l’Organisation internationale des constructeurs automobiles (OICA).

(23) BMVI, Automatisiertes und Vernetztes Fahren, op. cit.

(24) Jenkins R., « Autonomous Vehicles Ethics and Law: Toward and Overlapping Consensus », op. cit.

(25) Hevelke A. et Nida-Rümelin J., « Responsibility for Crashes of Autonomous Vehicles: an Ethical Analysis », op. cit.

(26) Jenkins R., « Autonomous Vehicles Ethics and Law: Toward and Overlapping Consensus », op. cit.

(27) Le principe de subsidiarité stipule qu’une responsabilité doit être prise par le plus petit niveau d’autorité publique compétent pour résoudre le problème. Ce principe qui trouve son origine dans la doctrine sociale de l’Église catholique est une règle de répartition des compétences entre l’Union européenne et ses États-membres. En l’occurrence pour une politique éthique du VA, le niveau européen ou international s’impose quant aux principes méta-éthiques et aux méthodes de construction des algorithmes d’IA, mais le niveau local est plus pertinent quant à la fréquence d’occurrence de certains dilemmes, ou bien la valorisation éthique de dispositifs culturels ou religieux, voire de certains agents (on pense ici par exemple aux vaches sacrées en Inde).

(28) BMVI, Automatisiertes und Vernetztes Fahren, op. cit.

(29) Villani Cédric (dir.), Donner un sens à l’intelligence artificielle : pour une stratégie nationale et européenne, mars 2018, rapport de mission parlementaire confiée par le Premier ministre Édouard Philippe, p. 22 (www.ladocumentationfrancaise.fr/).

(30) IEEE, Ethically Aligned Design (v1, December 2016), op. cit.

(31) Ce groupe de travail « Trilateral Automation in Road Transportation Working Group » sous les auspices de la « EU-US-JPN ITS Cooperation » se réunit tous les six mois lors de conférences internationales en Europe, aux États-Unis ou au Japon. Il est piloté pour le Japon par le MLIT (Ministry of Land, Infrastructure, Transport and Tourism), pour l’Europe par la Commission européenne et l’agence ERTICO-ITS Europe, et pour les États-Unis par le DoT (Department of Transport).

(32) IEEE, Ethically Aligned Design (v1, December 2016), op. cit.