Cet article examine une douzaine de ruptures technologiques, concrétisées aux XXe et XXIe siècles pour identifier les caractéristiques génériques de leur montée en maturité. Cette dynamique est similaire à celle d’une rupture de fatigue : elle est précédée d’un long travail, dont la durée s’exprime en décennies. Elle est aussi détectable à l’avance. En revanche, ces exemples contredisent l’idée d’une accélération technologique actuelle. Enfin, cet article examine les freins souvent rencontrés dans la montée en maturité des ruptures technologiques, et sur la façon de les limiter : garder un volume de recherche dédié aux avancées à long terme et améliorer le dialogue, à tous les niveaux, entre les militaires et les ingénieurs de la Direction générale de l’armement (DGA).

La dynamique de montée en maturité des ruptures technologiques

Il est fréquent d’entendre que l’époque actuelle est marquée par une accélération technologique sans précédent. Celle-ci induit l’arrivée rapide d’un certain nombre de ruptures technologiques, qui pourraient bouleverser l’équilibre des forces : l’hypervélocité, l’intelligence artificielle (IA) et les « dispositifs quantiques » sont souvent cités comme les technologies à maîtriser impérativement, sous peine de risquer un déclassement dans les conflits de demain (1). Mais quelle réalité temporelle recouvre ces notions de « demain » ou « rapide » : est-ce quasi-immédiat comme le laisse penser le tempo médiatique, ou parle-t-on à l’échelle géostratégique, au moins en années, voire plus ? En partant de l’examen de ruptures technologiques de l’histoire récente, concrétisées aux XXe ou XXIe siècles, je vais tenter de déterminer les caractéristiques de la dynamique de maturation des ruptures technologiques. Dans une première partie, je vais définir puis identifier des jalons dans l’histoire de différentes ruptures technologiques. Le lecteur pressé pourra rejoindre directement la seconde partie, dans laquelle j’examinerai les points communs qui se dégagent de ces exemples.

* * *

Dans le but de comparer la montée en maturité des différentes ruptures technologiques, depuis l’idée initiale, parfois totalement fictive à l’époque, jusqu’à l’utilisation opérationnelle, je définis 7 jalons permettant de repérer dans le temps cette progression :

• J1 – Idée/concept : l’application a été imaginée et décrite, mais sans forcément en avoir validé la faisabilité.

• J2 – Validation théorique ou premières expériences : soit la faisabilité a été vérifiée d’un point de vue théorique ou par simulations, soit les premières expériences destinées à tester la faisabilité ont été entreprises, sans nécessairement être un succès.

• J3 – Validation expérimentale : la faisabilité est démontrée et surtout vérifiée au moyen d’expériences effectuées en laboratoire.

• J4 – Prototype : un premier prototype a été réalisé et essayé en laboratoire.

• J5 – Premiers essais terrain : des essais sont réalisés sur un prototype, mais dans un environnement représentatif des contraintes du terrain.

• J6 – Expérimentation : le prototype ou les premiers exemplaires de série sont essayés, soit en centre d’essais, soit en opération mais à titre expérimental (doctrine et contraintes d’emploi ne sont pas forcément établies).

• J7 – Utilisation opérationnelle : le matériel est déployé et utilisé opérationnellement.

Les ruptures technologiques sélectionnées peuvent se répartir en deux catégories :

– des ruptures technologiques majeures, qui introduisent des systèmes n’existant pas auparavant et ont nécessité, en plus du développement technologique, l’invention de doctrines d’emploi ;

– des ruptures technologiques simples, qui apportent un saut de performance important, sans changer de concept.

Ruptures technologiques majeures

Avion

Voler a toujours fait partie des rêves des hommes : J1avion n’existe donc pas. Les débuts de l’avion remontent aux expériences de Clément Ader dans les années 1890. Je prends donc J2avion=1895. Ces expériences intéressent les militaires dès l’origine mais sont un échec. Le succès est venu en 1903 avec le premier vol effectué par les frères Wright (J3avion=1903). La période 1903-1913 est marquée par le paradoxe d’un développement très fort de l’avion notamment à des fins de spectacle de « cirque aérien » dans le civil et d’un relatif désintérêt militaire… Lequel n’empêche toutefois pas les armées d’investir et de créer les fondements de l’aviation militaire, même si cette dernière est souvent vue comme marginale. À partir de 1913 (J4avion), les concepts d’emploi commencent à se développer et l’armement des avions, auparavant cantonnés à l’observation, commence à être imaginé.

La Première Guerre mondiale donne lieu à une accélération spectaculaire, car elle est le théâtre de nombreuses expérimentations et améliorations, tout comme elle révèle les vulnérabilités de leur concurrent, l’aérostat. On peut alors définir J5avion=1914. L’emploi de l’aviation devient progressivement incontournable vers 1916-1917, ce qui nous donne J6avion=J7avion=1916.

Char

L’idée du char, engin mobile blindé et armé, est ancienne, puisque Léonard de Vinci en a dessiné un projet célèbre. Là encore, je renonce à identifier J1. L’invention des moteurs, notamment à explosion, dans les années 1880, le rend techniquement possible. Dès l’invention des automobiles, leur utilisation militaire est envisagée, comme estafette dès 1898 ou portant une arme. C’est cette date que je retiens comme J2char. Une première tentative d’automitrailleuse blindée est proposée par la société CGV (Charron-Girardot-Voigt) en 1902 (J3char) et améliorée en 1906, mais sans succès car trop chère et trop peu mobile en terrain réaliste. Elle est également très critiquée par les cavaliers : l’habitacle confiné leur est insupportable. Le début de la Première Guerre mondiale démontre l’intérêt de la mobilité offerte par les automobiles, tout comme le caractère indispensable du blindage. L’enlisement provoqué par la guerre des tranchées impose la recherche de nouvelles solutions, car l’infanterie ne peut pas progresser face aux mitrailleuses et aux fils de fer, et les véhicules existants ne peuvent franchir ces obstacles.

Fin 1915 (J4char), le colonel Estienne propose un engin blindé à chenilles et convainc l’état-major en mêlant technique et exposé des tactiques rendues possibles. La première expérimentation a lieu avec succès début 1916 (J5char) et une commande est passée, malgré l’hostilité des services techniques de la Direction des services automobiles (DSA). Ces chars sont engagés en avril 1917 (J6char) avec un succès mitigé. En parallèle, les services techniques de la DSA développent le char Saint-Chamond… mais oublient de le doter de dispositif permettant la vision du conducteur. Ces chars combattent à partir de mai 1917, mais également trop peu fiables, leur succès est tout autant mitigé.

Le succès vient de l’association entre le colonel Estienne (devenu général) et Louis Renault, qui conçoivent fin 1916 un char léger. Les critiques, toujours vives, de la DSA doivent s’effacer devant le succès des essais en mai 1917. Ces chars n’apparaissent en nombre au combat qu’à l’été 1918 (J7char), mais apportent une contribution décisive à la victoire finale.

Radar

La possibilité de détecter la présence ou le mouvement d’objets à l’aide d’ondes électromagnétiques a été exprimée par Nikola Tesla dès 1900 (J1radar). La première démonstration a eu lieu à Rotterdam en 1904 (J2radar) avec la détection par Christian Hülsmeyer de navires à 3 km. Toutefois l’idée n’intéresse pas vraiment et il faut attendre les années 1920-1930 pour la voir de nouveau proposée et expérimentée, notamment pour les applications militaires et surtout les années 1930-1940 pour constater l’éclosion des développements de prototypes. Un pas est franchi avec les « maquettes opérationnelles » de radar monostatique, fournissant direction et distance du mobile détecté, expérimentées en 1934 (J4radar) par R.M. Page au Navy Research Laboratories (États-Unis). La montée en puissance émise est lente et les premiers prototypes sont disponibles fin 1937 (J5radar) puis essayés début 1938 (J6radar), détectant des avions à 180 km. Sous l’effet d’accélération de la Seconde Guerre mondiale, certains de ces prototypes seront produits en séries et utilisés, alors même que les compétences des opérateurs restent à développer : par exemple, le radar de Pearl Harbor avait détecté l’arrivée des avions japonais à 200 km, mais, mal interprétée, cette information n’a pas été transmise. La célèbre Chain Home britannique est ainsi initiée dès 1937 et joue un rôle majeur dans la bataille d’Angleterre qui commence en 1940 (J7radar).

Sous-marins

L’idée du sous-marin date de la nuit des temps. J1 n’est donc pas identifiable. On considère souvent que le premier sous-marin militaire était le Turtle, inventé dans les années 1770 par David Bushnell, et utilisé opérationnellement, sans succès, en 1776 (J2sous-marin). Le premier sous-marin à être propulsé par un moteur a été le Plongeur, de la Marine française, lancé en 1863 (J3sous-marin) et essayé durant quatre ans sans être un total succès. En 1888 (J4sous-marin), l’Espagne lance un premier sous-marin, conçu par Isaac Peral, équipé de torpilles, mais dont l’autonomie est encore très limitée. Le projet est d’ailleurs rejeté par les autorités. La même année est lancé le Gymnote en France.

L’autonomie augmente avec le Morse, lancé en 1899 (J5sous-marin) puis la série des quatre Farfadet en 1901, qui sont opérés sans pouvoir être considérés comme aptes au combat car posant de gros problèmes de sécurité.

On peut considérer que les sous-marins sont testés en conditions réelles à compter de 1900 (J6sous-marin), année où sont mis en service à la fois l’USS Holland, conçu par John Philip Holland, qui combine moteur à combustion et propulsion électrique et le Narval dessiné par Maxime Laubeuf et lancé en 1899, qui inaugure les innovations que sont la double coque et les ballasts externes. Dès lors, les premières séries sont amorcées, notamment la série des Aigrette lancée en 1904 (J7sous-marin) et les sous-marins sont utilisés au combat durant la Première Guerre mondiale.

Missile

L’histoire des missiles peut remonter au XIe siècle, lorsque les Chinois expérimentent l’utilisation de flèches remplies de poudre noire. Cette poudre sert à la fois à la propulsion et à l’effet terminal (explosion). Cette invention se diffuse au XVIIIe siècle, en raison des dégâts qu’elle permet d’infliger à un adversaire : incendie, éclats à l’arrivée. Je définis donc J2missile=1790. Malgré quelques utilisations opérationnelles dans la première moitié du XIXe siècle, ces engins sont supplantés par les progrès de l’artillerie.

Les développements se poursuivent toutefois au début du XXe siècle, en visant plutôt les fusées spatiales, notamment avec les expérimentations menées par Robert H. Goddard à compter de 1926 (J3missile). Le tournant majeur vers les applications militaires se fait en Allemagne dès 1929, avec les « fusées » de type A1 et A2, essayées notamment en 1934 (J4missile) par Wernher von Braun. Ces développements sont poursuivis avec les essais des A3 en 1937, sans succès, puis des A5 en 1938 avec plus de réussite. Ces tests sont utilisés pour mettre au point la fusée A4 qui, après plusieurs échecs, démontrera ses capacités lors d’un vol en décembre 1942 (J5missile). La mise en production est décidée mais perturbée par les bombardements alliés. Les premiers tests opérationnels de ce qui est devenu le V2 sont effectués en septembre 1944 (J6missile) et mis en service la même année (J7missile).

Les V1, qui sont des intermédiaires entre missiles et drones, sont pour leur part mis en production en 1941 et opérationnels en 1944, ce qui ne change pas nos jalons.

Bombe atomique

Le concept de bombe atomique est décrit dès 1913 (J1BA) par le romancier H.G. Wells dans The World Set Free, en extrapolant depuis la découverte de la radioactivité par Henri Becquerel en 1896. Ce qui n’était que de la science-fiction a toutefois influencé, de son propre aveu, l’un des « pères » de la bombe atomique Léo Szilard, qui reprend l’idée dès 1933. Celle-ci ne prend toutefois une réalité scientifique qu’à partir de la découverte de la radioactivité artificielle par les Français Irène et Frédéric Joliot-Curie en 1934 (J2BA). En 1935, Frédéric Joliot évoquait la possibilité de réaliser des « transmutations [nucléaires] à caractère explosif ». Rapidement, la fission de l’atome d’uranium est démontrée expérimentalement par Otto Hahn et Fritz Strassman à Berlin fin 1938. En mars 1939, Frédéric Joliot, Hans Halban et Lew Kovarski puis Enrico Fermi et Léo Szilard montrent que cette fission s’accompagne de l’émission de plusieurs neutrons, élément clef pour déclencher une réaction en chaîne. Finalement, en avril 1940 (J3BA), Rudolf Peierls et Otto Frish mettent en évidence les améliorations liées à l’enrichissement en Uranium 235, ouvrant la voie à une bombe d’un poids raisonnable, dont ils décrivent les effets de l’explosion.

Portée à l’attention des autorités militaires britanniques comme américaines dès le début 1939, la possibilité de réalisation d’une bombe atomique ne rencontre qu’un intérêt limité voire un scepticisme. Cela n’arrête toutefois pas les travaux, notamment sous l’impulsion des savants immigrés d’Allemagne, qui craignent par-dessus tout que l’Allemagne nazie mette au point la première cette arme. Aux États-Unis, les célèbres courriers d’Albert Einstein au président Roosevelt, sur l’initiative de son conseiller Alexander Sachs et de Léo Szilard, changeront la donne. Les expériences réalisées en 1941 (J4BA) confirmant les extrapolations, la probabilité de réussite est alors estimée importante et des moyens considérables sont mobilisés à partir de 1942, année de lancement du projet Manhattan. La première expérience en grandeur nature a lieu dans le désert d’Alamogordo le 16 juillet 1945 et la première utilisation opérationnelle le 6 août 1945 sur la ville de Hiroshima. Les jalons 5, 6 et 7 sont donc tous passés en 1945.

Satellites militaires d’observation

Une première mention d’un satellite artificiel figure dans la nouvelle The Brick Moon (1869) de Edward Everett Hale, mais la première évocation scientifique d’un objet orbitant autour de la Terre est due à Constantin Tsiolkovski en 1903 (J1satellite). En 1928 (J2satellite), Herman Potocnik décrit comment des vaisseaux spatiaux placés en orbite peuvent être utilisés pour des observations pacifiques et militaires de la surface de la Terre.

Le premier satellite artificiel est le célèbre Spoutnik 1, lancé par l’URSS le 4 octobre 1957 (J3satellite), qui démontre la faisabilité d’une mise en orbite, sans disposer de moyen d’observation. Les satellites d’observation militaire apparaissent toutefois très vite car les batteries antiaériennes protègent de mieux en mieux les installations militaires russes des avions espions : il s’agit de la série des Corona américains, dont le premier lancement intervient en juin 1959 (J6satellite). Il faudra 20 lancements pour atteindre la maturité : J7satellite est donc 1960.

GPS

Le GPS est né de la conjugaison d’une idée et d’une constatation expérimentale. L’idée, attribuée au docteur Ivan Getting, consiste à utiliser la différence de temps de parcours d’ondes électromagnétiques entre trois émetteurs distincts pour réaliser une triangulation, donc une localisation d’un mobile, qui était, dans les années 1960, un lanceur de missiles stratégiques sur rails (2). La constatation expérimentale est faite par William Guier et George Weiffenbach au sein de l’Applied Physics Laboratory (APL) de l’Université Johns Hopkins, suite au lancement de Spoutnik en 1957 (J2GPS) : en utilisant l’effet Doppler, ils peuvent déterminer la position du satellite… en mobilisant l’un des plus puissants calculateurs de l’époque ! Cela conduit l’APL à développer le projet TRANSIT pour résoudre le problème inverse : localiser l’utilisateur en connaissant la position des satellites. Ce projet est basé sur une constellation de 5 satellites et testé avec succès en 1960 (J3GPS), même s’il faut alors une heure pour déterminer la position.

L’US Navy développe ensuite, sous la direction du physicien Roger L. Easton, le projet TIMATION, dont l’objectif est de placer une horloge précise en orbite. Le premier satellite est lancé en 1967, mais le plus important est le troisième, lancé en 1974 (J4GPS) : il emporte la première horloge atomique en orbite. En parallèle, l’US Air Force conduit un projet similaire : le projet 621B.

En 1973, il est décidé de lancer le projet Navstar-GPS (3), sous la direction du colonel Bradford Parkinson. Le premier satellite, expérimental, est lancé en 1978 (J5GPS) suivi, jusqu’en 1985 par dix autres. Les satellites plus modernes (Block-II) sont lancés à partir de 1989 et les récepteurs sont développés en parallèle.

Le GPS est très largement utilisé pendant la première guerre du Golfe (1990-1991), même si le système est encore incomplet : la capacité initiale ne sera officiellement atteinte qu’en 1993. Je considère donc que J6GPS=1990. La capacité opérationnelle complète est déclarée en 1995 (J7GPS).

Ruptures technologiques « simples »

Propulsion électrique spatiale

La propulsion électrique spatiale consiste à accélérer électriquement les particules éjectées pour propulser un satellite ou une sonde. Cela permet, pour une masse stockée identique, d’augmenter considérablement la propulsion. L’inconvénient est une complexité plus élevée que la propulsion par des gaz de combustions éjectés d’une tuyère.

Le concept a été décrit par Robert H. Goddard en 1906, mais ses notes, privées, ne seront publiées que beaucoup plus tard. Indépendamment, Constantin Tsiolkovski l’imagine et le publie en 1911 (J1EP). L’idée est reprise et développée par Hermann Oberth en 1929, mais la véritable validation théorique n’est effectuée qu’en 1951 (J2EP) par Lyman Spitzer. Les premières recherches pratiques démarrent dans les années 1960, au début de l’ère spatiale. Un premier moteur électrique est installé à bord des satellites météorologiques soviétiques Meteor (premier lancement en 1971, J3EP et J4EP) et constitue la première expérimentation de la propulsion électrique spatiale, sans réelle suite jusqu’au lancement, par le Japon en 1995 (J5EP et J6EP) du satellite Engineering Test Satellite VI. La première utilisation commerciale, qui marque la pleine maturité, débute en 1997 (J7EP) avec le lancement de satellites de télécommunications Hughes équipés de moteurs Xenon Ion Propulsion System (XIPS).

GaN

La technologie basée sur les semiconducteurs en nitrure de Gallium (GaN) possède plusieurs applications. Celle qui nous intéresse ici est la réalisation de composants hyperfréquences, utilisés dans les systèmes de radar, de guerre électronique ou de communication. Elle est destinée à remplacer une partie des composants en arséniure de Gallium (AsGa), technologie actuellement majoritaire : plus robustes, les composants GaN autorisent en effet des puissances 10 à 50 fois supérieures, ce qui a un impact significatif sur les performances des systèmes.

Je décris ici la montée en maturité de la technologie en Europe, faute de données publiques détaillées sur celle effectuée aux États-Unis, avec une avance de quelques années. Le Japon est aussi un acteur important, mais visant des applications civiles.

Connues depuis longtemps sur le plan théorique, les possibilités des composants hyperfréquences en GaN commencent à être démontrées dans les laboratoires de recherche au milieu des années 1990 : je prends donc J2GaN=1990 et J3GaN=1995. En France, après quelques explorations, qui conduisent notamment à écarter la solution concurrente en carbure de silicium (SiC) pour ces applications, la Direction générale de l’armement (DGA) lance les premiers développements appliqués en 2001. Il apparaît que le développement de cette filière est hors de portée de la France seule, l’intérêt manifesté par les développeurs de systèmes étant limité à cette date. En 2003 (J4GaN), les résultats obtenus, en France comme dans d’autres pays, conduisent les ministères de la Défense allemand, britannique, italien, espagnol, hollandais, suédois et français à s’associer pour lancer, en 2005, le projet Korrigan visant à développer industriellement la technologie. Celle-ci est qualifiée en 2011 (J5GaN) chez la société United Monolithic Semiconductors puis utilisée dans des prototypes de radar développés à partir de 2015 et essayés en 2019 (J6GaN). Même si certains systèmes actuels utilisent des composants GaN de type « télécom », la première utilisation opérationnelle de la version militaire de la technologie en France sera probablement le radar Sea Fire de la Frégate de défense et d’intervention (FDI), dont la mise en service est prévue en 2023 (J7GaN).

Micro-bolomètres infrarouge non refroidis

Ces micro-bolomètres sont surtout utilisés en vision nocturne. Ils présentent l’immense avantage de fonctionner à température ambiante et non à température cryogénique. De ce fait, les équipements qui les utilisent sont plus petits, consomment moins et sont plus discrets acoustiquement. Ils sont donc particulièrement adaptés à l’utilisation par un fantassin. Leur inconvénient est de présenter une résolution et une sensibilité nettement moindres : tout l’enjeu de la rupture a été de les amener à un niveau de performances permettant l’utilisation opérationnelle.

Le principe du bolomètre, qui utilise la variation de température pour mesurer un rayonnement, remonte historiquement à la découverte du rayonnement infrarouge par Frederick William Herschel, en 1800. Le premier saut de performance considérable, notamment en sensibilité, est ensuite réalisé par Samuel Pierpont Langley en 1880 (J1IRNR) et au cours des vingt années suivantes. Toutefois, le temps de réponse assez lent de ces détecteurs les pénalise et la plupart des développements ultérieurs se concentrent sur les détecteurs photoélectriques. Cependant, ces derniers présentent l’inconvénient de devoir être refroidis à très basse température. La recherche sur des détecteurs non refroidis basés sur des bolomètres miniaturisés reprend de la vigueur au début des années 1970 aux États-Unis, poursuivie par des développements classifiés. Faute de plus ample information, je prends J2IRNR=1975. Ce n’est qu’en 1992 (J3IRNR) qu’est publiée la réalisation de plan focaux capables de réaliser une image infrarouge. Les performances de l’époque, insuffisantes pour des applications militaires, laissent toutefois entrevoir le potentiel de la technologie, qui est alors développée dans plusieurs pays. En France, les premières études démarrent vers 1994 au Commissariat à l’énergie atomique (CEA), avec le soutien de la DGA à partir de 1996, contre l’avis de la hiérarchie de l’époque. Un premier démonstrateur est disponible en 2001 (J4IRNR) et permet de lancer l’industrialisation en parallèle. Malgré un retard estimé à 3 ans à l’époque sur les Américains, le développement sera poursuivi pour aboutir à des performances militairement utiles en 2008 (J5IRNR). Cela permet l’intégration dans le programme Félin (Fantassin à équipements et liaisons intégrés), en substitution aux détecteurs israéliens ou américains initialement envisagés, dont l’approvisionnement s’était révélé impossible. La mise en service se fait donc avec ce programme à partir de 2010 (J6IRNR). Cette substitution explique le délai exceptionnellement bref pour l’intégration dans un programme. Le premier déploiement opérationnel a lieu en 2013 (J7IRNR) lors de l’opération Barkhane.

Gravimètre à atomes froids

Les gravimètres mesurent la gravité, c’est-à-dire l’accélération due à l’attraction terrestre. L’intérêt militaire est que cette attraction varie, très légèrement, localement en fonction de l’environnement situé sous le point de mesure : densité des roches, présence d’eau… En mesurant très finement la gravité (la précision à atteindre est de l’ordre de 10-9), et en disposant d’une cartographie géo-référencée, on obtient donc une méthode de recalage sur le terrain. L’intérêt est que ces mesures se font de façon parfaitement discrète et non brouillable.

L’idée d’utiliser les atomes froids pour réaliser une mesure de l’accélération, et en particulier de la gravité, date des années 1980. Faute d’indication plus précise, je considère J1gravimètre=1985. Un rapport interne de la DGA recommande d’explorer ce concept dès 1987. Les premières études sont financées à partir de 1991 pour le valider en laboratoire (J2gravimètre=1995) et sont poursuivies pour monter progressivement en maturité. En 2011 (J3gravimètre), le niveau atteint permet de prendre confiance et entraîne la création de l’entreprise µQuans, qui porte les développements au côté de l’Onéra (Office national d’études et de recherches aérospatiales) et de différents laboratoires. Aujourd’hui, la maturité est suffisante pour envisager d’embarquer ces dispositifs sur les bâtiments océanographiques : la commande a été passée en 2020 (J4gravimètre), pour des expérimentations qui débuteront probablement vers 2023 (J5gravimètre) et sans doute un embarquement expérimental sur sous-marin aux alentours de 2030 (J6gravimètre). Le déploiement opérationnel, qui nécessite au préalable d’avoir réalisé la cartographie des zones d’intérêt, n’est toutefois envisagé qu’à bord des SNLE3G, entre 2035 (J7gravimètre) et 2040.

* * *

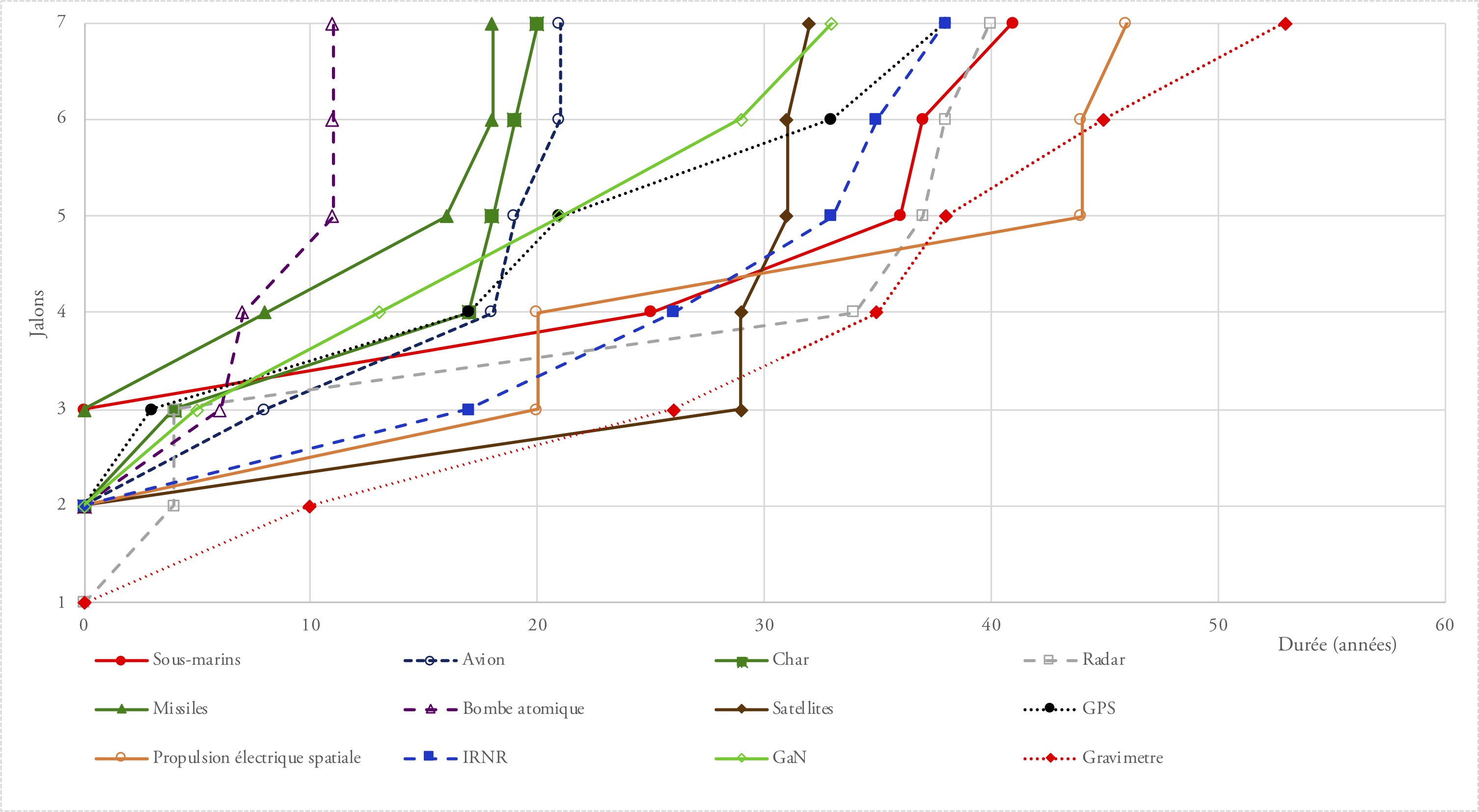

Figure 1 : frise temporelle retraçant la montée en maturité des ruptures technologiques considérées.

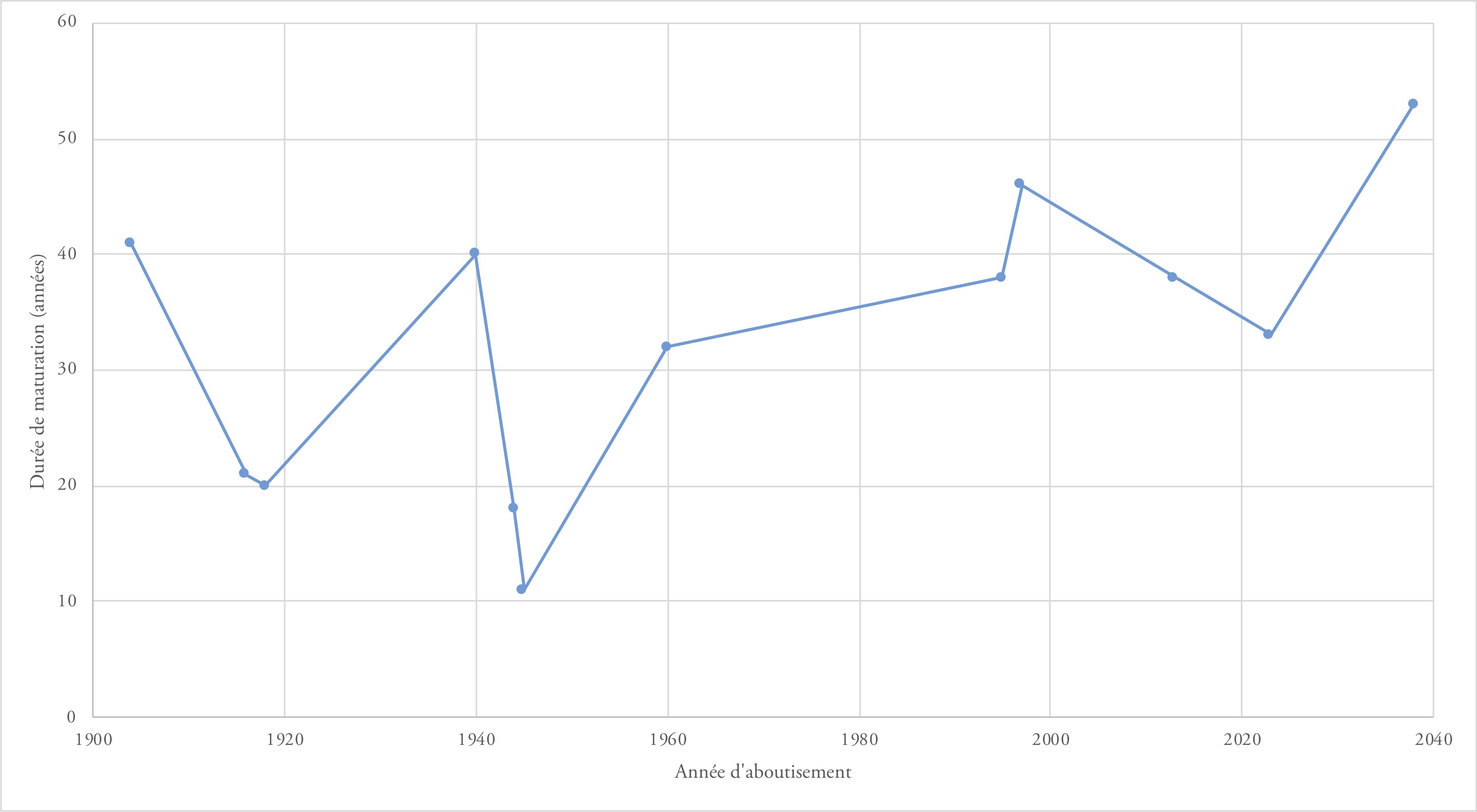

Figure 2 : durée de la montée en maturité des différentes ruptures technologiques depuis le premier jalon significatif.

Figure 3 : durée de la montée en maturité des différentes ruptures technologiques en fonction de l’année d’aboutissement (J7).

Le premier constat que l’on peut tirer de cette accumulation d’exemples est que le temps caractéristique de maturation des ruptures technologiques se compte en décennies : il s’écoule typiquement de 20 à 40 ans entre le jalon 2 et le jalon 7. Parmi les exemples étudiés, seul le développement de la bombe atomique est sensiblement plus court. Cela s’explique, d’une part, en raison du facteur accélérateur que représente la guerre et, d’autre part, par une concentration absolument exceptionnelle de moyens, tant matériels et financiers qu’en potentiel scientifique : au moins 6 titulaires de prix Nobel ont été impliqués dans le développement. Une telle concentration d’effort a une probabilité faible de se reproduire en dehors d’un conflit majeur.

La rupture technologique nécessite donc du temps, ce qui va à l’encontre de l’idée de soudaineté véhiculée par le terme « rupture ». Toutefois, la métaphore mécanique peut être conservée si l’on précise que la rupture technologique est assimilable à une rupture de fatigue : la concrétisation (cassure) est brutale, mais elle est précédée d’un long travail, peu visible… toutefois détectable par qui dispose des moyens d’examen appropriés. C’est effectivement le cas des ruptures technologiques, avec un préavis très important : à l’exception peut-être du GPS, toutes celles examinées ici ont été décrites d’abord dans la littérature ouverte, au moins au stade de maturité peu élevée. Sous réserve d’effectuer une veille technologique et scientifique, les technologies susceptibles d’apporter une rupture sont donc identifiables par les experts, longtemps à l’avance. Bien évidemment, pour des développements militaires, une confidentialité peut être imposée lors de la montée en maturité pour tenter de faire oublier l’existence de ces technologies et leurs capacités d’évolutions. Toutefois, une veille efficace permet souvent de mettre à jour des indices. Les ruptures technologiques ne devraient donc pas être des surprises.

Le deuxième constat est que les ruptures technologiques ne mûrissent pas plus vite aujourd’hui qu’il y a 100 ans, au contraire : il a fallu moins de temps entre les expériences de Clément Ader et l’utilisation opérationnelle de l’avion que pour développer les micro-bolomètres infrarouges, qui constituent pourtant une rupture d’ampleur nettement moindre !

La notion d’accélération des ruptures technologiques est manifestement un leurre : parmi les exemples étudiés, toutes celles qui ont mûri en moins de 25 ans ont abouti dans la première moitié du XXe siècle, début de la période étudiée. Bien évidemment, les deux guerres mondiales expliquent en partie ce constat : les ruptures, alors vues comme une façon de prendre l’avantage, bénéficient de moyens plus importants. L’urgence autorise également une plus grande prise de risque et une capacité d’expérimentation plus rapide. Cet effet accélérateur des guerres est particulièrement visible dans les figures 2 et 3 : les ruptures technologiques ayant débouché pendant les guerres mondiales ont pris entre 13 et 21 ans, les autres entre 32 et plus de 50 ans. Inversement, le ralentissement de la maturation des ruptures technologiques militaires peut sans doute s’expliquer en partie par la baisse sensible des budgets militaires, donc des moyens consacrés aux recherches, et en particulier aux travaux les plus risqués et les plus novateurs.

Il reste intéressant de s’interroger sur les raisons de notre perception erronée d’une accélération technologique. Plusieurs effets peuvent y contribuer :

• Une partie des évolutions du monde moderne est portée par des « applications », qui sont en fait des logiciels. Or, les logiciels peuvent effectivement être développés et distribués très rapidement. Mais ce ne sont pas des révolutions technologiques.

• La plupart des évolutions technologiques actuelles sont issues des technologies dérivées de la microélectronique. Ces dernières offrent une possibilité d’industrialisation rapide, car l’effort pour passer d’un prototype fonctionnel à la production en série est très limité : ils sont élaborés sur les mêmes chaînes de production aux très fortes capacités. À partir de la présentation d’un prototype quelques mois suffisent alors pour atteindre des millions d’utilisateurs. Mais cela occulte le fait que le temps nécessaire pour aboutir au prototype a souvent été long.

• Le développement d’Internet, et de l’ensemble des informations qui y sont intégrées, a réduit à presque rien le temps et le coût d’accès à une information. Cette révolution, dont l’ampleur est proche de celle de l’invention de l’imprimerie (1454), s’est étalée sur plusieurs décennies, mais est maintenant bien en place. Par la diffusion des informations qu’elle assure, elle multiplie les possibilités d’innovation : chacun peut assembler des technologies sur étagère, d’origines très variées, dans des usages nouveaux. Cette capacité d’innovation, parfois appelée « innovation d’usage », peut être très rapide : c’est, par exemple, l’utilisation de petits drones commerciaux pour larguer des explosifs. Mais elle ne constitue pas une rupture technologique : les technologies utilisées existent déjà, la rupture a donc eu lieu avant.

Le temps est, en fait, un constituant essentiel de la rupture technologique. Par définition, une rupture technologique consiste à inventer, ou au moins à mettre au point, des technologies qui n’existent pas encore, et qui sont assez éloignées des technologies existantes : sinon, il ne s’agit pas d’une rupture mais d’une évolution ou d’un développement. Concrétiser une rupture technologique demande donc une somme d’efforts importants : il faut tout d’abord obtenir en laboratoire l’effet recherché, et en cas de succès, rendre la technologie fiable puis robuste – c’est-à-dire capable d’être employée sur le terrain – et généralement en diminuer le coût. Cela demande du temps. Il peut être en partie réduit, par exemple en y consacrant des moyens colossaux, mais pas ramené à zéro.

Le troisième constat est qu’une rupture technologique doit surmonter plusieurs types de freins au cours de sa maturation :

– Surtout si elle induit un nouveau concept d’emploi (avion, sous-marin ou radar, par exemple), elle rencontre très souvent une phase de rejet, pendant laquelle l’opinion majoritaire est que « ça ne sert à rien ». Cette phase n’arrête pas forcément le développement, sous l’impulsion de « visionnaires » parfois marginalisés, mais elle le ralentit considérablement.

– Pour les exemples les plus récents, le manque global de moyens a souvent conduit à choisir de concentrer les efforts sur des évolutions à court et moyen termes plutôt que sur des ruptures dont on a vu que le terme était par essence plus lointain.

– Enfin, certaines ruptures demandent d’agréger des technologies qui n’étaient tout simplement pas prêtes, ni sur le point de l’être : par exemple, les sous-marins ont dû attendre le développement des moteurs pendant presque un siècle.

Devoir attendre la maturité de technologies est inhérent au concept de rupture technologique, mais il est possible de travailler pour réduire les deux autres freins. En théorie, la tendance la plus simple à combattre est celle de la concentration des efforts sur le court terme : il « suffit » de décider qu’une proportion des études doit être consacrée aux développements de long terme. Le faire en pratique est plus compliqué. D’une part, la tentation de revenir à ce qui produit des effets à court terme, donc, en particulier exploitables politiquement, existe toujours. D’autre part, il est généralement facile de prévoir des mécanismes de soutien pour les développements très exploratoires, qui coûtent relativement peu cher. Mais il existe une « vallée de la mort technologique », qu’il faut franchir pour faire mûrir la technologie, avec des besoins en moyens qui augmentent sensiblement alors que le terme d’application reste encore lointain et que les chances de succès restent incertaines. En France, la création de l’Agence pour l’innovation de Défense (AID), et surtout l’augmentation des budgets de recherche, contribuent à lever ce frein.

Combattre l’effet de rejet d’une rupture est beaucoup plus compliqué. Les exemples présentés ici démontrent la nécessité d’une persévérance dans le temps et les effets dommageables des doutes ou rejets. Toutefois, la vision est déformée par le fait que je n’ai sélectionné que des ruptures qui ont abouti. Or, ce n’est pas toujours le cas, même si elles sont soutenues par de nombreux scientifiques de haut niveau : par exemple, le protocole de cryptographie quantique proposé par Charles H. Bennett et Gilles Brassard en 1984 (appelé BB84) fait toujours l’objet de développements alors même qu’il ne présente aucun intérêt opérationnel : il nécessite une authentification des interlocuteurs dont l’existence même le rend inutile.

Le tri des ruptures proposées est donc indispensable, et une priorisation l’est souvent aussi, faute de moyens suffisants pour tout développer. Comment faire ce choix ? Historiquement, les concepts novateurs tels que le char ou le sous-marin, ont pu être portés par des officiers ayant une très bonne connaissance des technologies de leur époque. Cette situation est moins probable aujourd’hui, en raison de la complexification de chaque domaine technologique. Inversement, les ingénieurs, même spécialisés et à l’écoute des opérationnels, connaissent surtout les capacités, besoins et contraintes actuels. Par conséquent, ce n’est que par le dialogue entre opérationnels et ingénieurs que la consolidation du besoin de développer une technologie en rupture peut s’effectuer. Un tel dialogue existe, notamment au sein de la structure commune entre l’EMA/COCA (État-major des armées/division Cohérence capacitaire) et DGA/SASD (service d’architecture du système de défense), mais il ne doit pas être cantonné à ce niveau élevé : en effet, évaluer la faisabilité d’une rupture nécessite souvent une connaissance d’expert pointue, tout comme l’estimation des avantages produits et de l’acceptabilité (ou non) des contraintes induites nécessite une vision opérationnelle précise.

Cette vision construite en commun du besoin de développer une rupture technologique particulière est également un excellent moyen d’assurer la persévérance de l’effort durant le temps long nécessaire à la maturation. Elle facilite aussi l’insertion des technologies dans les systèmes : en effet, si la rupture technologique devient disponible alors qu’aucun développement système susceptible de l’utiliser n’est prévu, elle doit attendre que ce développement s’insère dans la programmation militaire, ce qui peut prendre des années.

Une des façons d’agir contre les freins au développement des ruptures technologiques pertinentes est donc de renforcer le dialogue entre les opérationnels, militaires des armées, et les experts, notamment de la direction technique de la DGA, à tous les niveaux. On peut d’ailleurs imaginer que ces interactions accrues, qui ne sont pas nécessairement très coûteuses en ressources humaines, conduiraient à une meilleure connaissance mutuelle des contraintes opérationnelles et des possibilités techniques, ce qui bénéficierait à l’ensemble des programmes d’armement.

* * *

Bien que l’accumulation d’exemples ne constitue pas une démonstration rigoureuse, l’examen d’une douzaine de ruptures technologiques, concrétisées aux XXe et XXIe siècles permet de confirmer qu’une rupture technologique est similaire à une rupture de fatigue : elle est précédée d’un long travail, dont la durée s’exprime en décennies. Comme la rupture de fatigue, la rupture technologique est aussi détectable à l’avance : elle est quasiment toujours d’abord décrite dans la littérature ouverte, et donc peut être remarquée au moyen d’une veille technologique et scientifique efficace. En revanche, les exemples examinés contredisent l’idée d’une accélération technologique actuelle : la maturation des ruptures technologiques n’est pas plus rapide de nos jours qu’il y a un siècle. Le seul effet accélérateur très net est celui des deux guerres mondiales.

Mais si le temps est une composante essentielle d’une rupture technologique, la durée de la maturation de celle-ci peut être réduite en agissant sur deux freins fréquemment rencontrés : d’une part, la tendance à concentrer des moyens généralement limités sur le plus court terme et, d’autre part, l’effet de rejet. Une structure comme l’AID, en charge de toutes les échelles de temps, est pertinente pour le premier. Lutter contre le second plaide pour renforcer le dialogue à tous les niveaux entre les opérationnels et les experts techniques de la DGA, dialogue raisonnablement peu coûteux dont les bénéfices dépasseraient certainement le périmètre des ruptures technologiques.

Éléments de bibliographie

Bennett Charles H. et Brassard Gilles, « Quantum Cryptography: Public Key Distribution and Coin Tossing », Theoretical Computer Science, vol. 560, 1984, p. 7-11.

Berman Robert et Gunston Bill, Les Missiles, Édition Bordas, 1984, 192 pages [traduit de Rockets & Missiles of World War III, Éditions Bison Books Corp., 1983].

Choueri Edgar Y., « A Critical History of Electric Propulsion: the First Fifty Years (1906-1956) », Journal of Propulsion and Power, vol. 20, n° 2, 2004, p. 193-203 (https://mae.princeton.edu/).

Darricau Jacques et Blanchard Yves, Histoire du radar dans le monde puis en France (www.radars-darricau.fr/).

Delmas Claude, La bombe atomique, Éditions Complexe, 1985, 200 pages.

Ferrard Stéphane, Engins blindés français. Cent ans d’histoire, Éditions E/P/A, 1996, 144 pages.

Goya Michel, La chair et l’acier, Éditions Tallandier, 2004, 479 pages.

Kistchinky Andrey, « Ultra-Wideband GaN Power Amplifiers – from innovative technology to standart products » in Matin Mohammad (dir.), Ultra Wideband Communications: Novel Trends—System, Architecture and Implementation, Éditeur IntechOpen, 2011, chapitre XI (www.intechopen.com/).

Mathey Jean-Marie et Sheldon-Duplaix Alexandre, Histoire des sous-marins, des origines à nos jours (3e édition), 2018, E-T-A-I, 224 pages.

Olivier Jean-Marc (dir.), Histoire de l’Armée de l’air et des forces aériennes françaises du XVIIIe siècle à nos jours, Éditions Privat, 2014, 548 pages.

Piéplu Jean-Marc, GPS et Galileo Systèmes de navigation par satellites, Éditions Eyrolles, 2006, 166 pages.

Rogalski Antoni, « History of Infrared Detectors », Opto-Electronics Review vol. 20, n° 3, septembre 2012, p. 279-308. ♦

(1) « Dans le domaine militaire, les chocs sont, là aussi, multiples, souvent favorisés par des ruptures technologiques majeures comme l’avènement annoncé des systèmes hyperconnectés par la 5G, de l’intelligence artificielle (IA), de l’hypervélocité ou encore du quantique ». Lecointre François, « Préface », Cahier de la RDN « 2020 : chocs stratégiques », 2020, p. 9-10 (https://www.defnat.com/e-RDN/vue-article-cahier.php?carticle=227).

(2) Les documents consultés sont peu précis sur la date de cette idée, car le système était confidentiel à l’époque. Il n’est donc pas possible de déterminer un J1GPS antérieur à J2GPS=1957.

(3) GPS est l’abréviation de Global Positionning System, mais l’attribution de la signification « NAVigation System using Timing And Ranging » au terme Navstar est sans doute postérieure.